30. Januar 2026 von Dr. Michael Peichl

Vom Datensilo zu KI-Agenten: Data Intelligence im Mittelstand

In der betrieblichen Realität vieler Industrieunternehmen führen Ausfälle kritischer Komponenten oft noch zu manuellen, zeitintensiven Prozessen: Telefonate, E-Mail-Korrespondenz und das händische Abgleichen von Excel-Listen prägen den Arbeitsalltag. Dies bindet wertvolle Kapazitäten.

Wir stehen aktuell an einem technologischen Wendepunkt. Die Ära der rein deskriptiven Analytik – also das Betrachten vergangener Ereignisse in Dashboards – wird durch Agentic AI erweitert. Dabei handelt es sich um Systeme, die Daten nicht nur visualisieren, sondern auf deren Basis autonom Handlungsoptionen ableiten und ausführen.

Szenario 1: Automatisierte Beschaffungsprozesse

Ein KI-Agent in einer modernen Data-Intelligence-Umgebung agiert proaktiv. Erkennt ein Sensor einen drohenden Fehlbestand, wartet das System nicht auf menschliches Eingreifen. Der Agent prüft den Lagerbestand im SAP-System, vergleicht Lieferantenpreise in Echtzeit und bewertet Lieferzeiten basierend auf historischen Logistikdaten. Das Ergebnis ist ein vorbereiteter Bestellsatz, den der Einkauf lediglich freigeben muss.

Dies entlastet Fachkräfte von administrativen Routineaufgaben und beschleunigt die Supply Chain.

Szenario 2: Digitalisierung von Expertenwissen im Anlagenbau

Ein weiteres Anwendungsfeld ist die Angebotserstellung für komplexe Sonderanlagen. Häufig hängt die Kalkulation am impliziten Erfahrungswissen weniger langjähriger Mitarbeitender, die ähnliche Projekte aus der Vergangenheit als Referenz heranziehen. Tritt diese Generation jedoch in den Ruhestand, entsteht oft eine kritische Wissenslücke, da dieses Erfahrungswissen selten strukturiert dokumentiert ist und somit das Unternehmen verlässt.

Ein KI-Agent auf der Databricks Data Intelligence Platform kann dieses implizite Wissen explizit nutzbar machen und konservieren. Er analysiert historische CAD-Zeichnungen, technische Spezifikationen (PDFs), Kalkulationstabellen und Projektkommunikation der letzten Jahre.

Das System erkennt Muster: „Das angefragte Modul weist eine 90-prozentige Ähnlichkeit zum Projekt von 2018 auf, wobei die Materialkosten für Stahlindex-bereinigt heute 20 Prozent höher liegen.“

Der Agent generiert einen datengestützten Kalkulationsentwurf. Dies ersetzt nicht die Ingenieursleistung, reduziert aber die Recherchezeit von Tagen auf Minuten und sichert wertvolles Unternehmenswissen dauerhaft gegen Fluktuation ab.

Das technische Fundament: Die Data Intelligence Platform

So vielversprechend diese Szenarien sind, so oft scheitern sie in der Praxis an der Dateninfrastruktur. Ein KI-Agent, der auf fragmentierte CSV-Exporte und Datensilos zugreift, kann keine verlässlichen Entscheidungen treffen (das Prinzip „Garbage In, Garbage Out“).

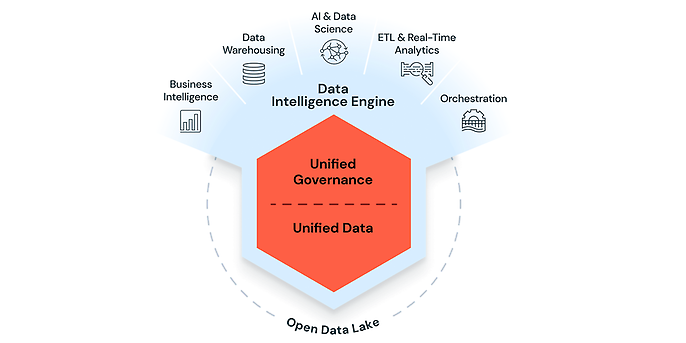

Databricks adressiert dieses Problem mit der Lakehouse-Architektur (Data Lakehouse Architecture | Databricks), die als zentraler Integrationspunkt dient:

- Einheitliche Datenbasis: Strukturierte Finanzdaten aus dem ERP und unstrukturierte Wartungsprotokolle werden an einem Ort konsolidiert. Der Agent erhält so den vollständigen Kontext.

- Semantisches Verständnis: Die Plattform nutzt KI, um die Struktur und Bedeutung der Unternehmensdaten zu indizieren, was manuelle Optimierungsschritte reduziert.

- Mosaic AI (Databricks GenAI Announcements at Data + AI Summit 2024 | Databricks Blog) und Agent Bricks (Agent Bricks | Databricks): Databricks stellt ein modulares Framework bereit, um Agenten nach standardisierten Mustern zu entwickeln, zu testen und im Betrieb zu überwachen.

Intelligent. Einfach. Privat. - Quelle: Databricks IQ: AI-Driven Analytics for Faster Data Insights | Databricks

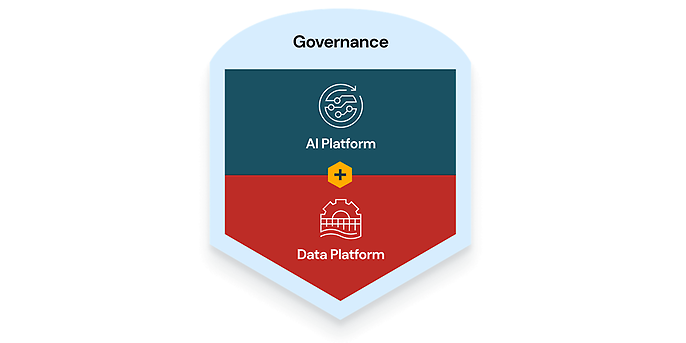

Governance mit Unity Catalog: Compliance by Design

Ein zentrales Hemmnis für KI-Projekte im Mittelstand ist die Datensicherheit. Es muss technisch sichergestellt sein, dass sensible Daten (zum Beispiel HR-Informationen oder Umsatzzahlen) nicht unberechtigt verarbeitet werden.

Die Antwort von Databricks ist der Unity Catalog (Unity Catalog | Databricks). Er fungiert als zentrale Governance-Schicht. Bei der Implementierung von Agenten-Lösungen werden an dieser Stelle die Zugriffsregeln definiert: Ein Service-Agent darf beispielsweise Produktdaten lesen, erhält jedoch keinen Zugriff auf Personaldaten.

Diese Governance wird zentral durchgesetzt – unabhängig davon, ob der Zugriff durch einen Data Scientist, einen Analysten oder einen KI-Agenten erfolgt. Dies ermöglicht den rechtssicheren Einsatz von RAG (Retrieval Augmented Generation) im Unternehmenskontext.

Quelle: Databricks IQ: AI-Driven Analytics for Faster Data Insights | Databricks

Kosteneffizienz durch Serverless-Architektur

Hinsichtlich der Betriebskosten bietet Databricks mit Serverless Compute (Serverless computing | Databricks) ein flexibles Modell. Ressourcen müssen nicht dauerhaft vorgehalten werden. Ist ein Agent inaktiv, fallen keine Compute-Kosten an. Bei Lastspitzen – etwa der Prüfung tausender Dokumente am Monatsende – skaliert die Leistung automatisch. Dies macht Enterprise-Technologie auch für den Mittelstand kalkulierbar und wirtschaftlich effizient.(Mehr dazu lest ihr in unserem Blog zu FinOps: DBU-Optimierung & TCO-Rechnung für DWH-Migration).

Wie adesso den Weg zur „Agentic Enterprise“ gestaltet

Die Technologie ist die Basis, entscheidend ist jedoch die Integration in die bestehende Systemlandschaft (SAP S/4HANA, Salesforce, Legacy-Systeme).

Bei adesso verbinden wir technische Expertise mit Prozessverständnis für den Mittelstand. Wir implementieren nicht nur die Plattform, sondern realisieren Use Cases mit messbarem ROI:

- Intelligente Dokumentenverarbeitung: Automatisierte Validierung von Eingangsrechnungen und Lieferscheinen.

- Predictive Maintenance Agents: Autonome Störungsmeldung durch Maschinen inklusive Lösungsvorschlag und Ersatzteilidentifikation für das Technik-Team.

Die Data Intelligence Platform ist bereit. Ist eure Datenstrategie es auch?

Deep-Dive Themen: Die Serie im Überblick

Dieser Artikel skizziert das strategische Gesamtbild. In unserer Blog-Serie vertiefen wir spezifische Aspekte der Plattform für unterschiedliche Rollen. Hier findet ihr die direkten Links zu den Deep Dives:

- Für IT-Leitung & SAP-Architektur: SAP-Daten befreien: Nahtlose Integration ins Lakehouse ohne Replikationsaufwand

- Für CISOs & Compliance-Management: Unity Catalog und Open-Source: Compliance & Security für den Mittelstand

- Für Innovation Manager & AI Engineers: Agent Engineering statt Spielerei: Der Weg zu sicheren KI-Anwendungen mit Mosaic AI

- Für Data Engineers & IT-Ops: Databricks Lakeflow & Lakebase: Architektur-Vereinfachung für Data Engineers 2026

- Für CFOs & Cloud-Verantwortliche: Databricks FinOps: DBU-Optimierung & TCO-Rechnung für DWH-Migration

Fazit

Die Databricks Data Intelligence Platform liefert das technologische Fundament – adesso die Strategie für die Integration. Lasst uns evaluieren, wie ihr eure Datenlandschaft modernisieren und isolierte Lösungen in eine einheitliche, intelligente Plattform überführen könnt. Unsere Expert:innen begleiten euch von der Architekturplanung bis zum produktiven KI-Einsatz, um Prozesse zu automatisieren und Innovationszyklen zu verkürzen.

Wir unterstützen euch!

adesso unterstützt euch dabei, den optimalen Einstieg in eure datengetriebene Transformation zu finden und die strategischen Potenziale Ihrer Datenplattform voll auszuschöpfen.

Jetzt Discovery Workshop vereinbaren und gemeinsam mit unseren Fachleuten:

- Herausforderungen und Ziele analysieren,

- individuelle Handlungsfelder identifizieren,

- konkrete Next-Steps für Ihre Databricks-Roadmap ableiten.