20. Februar 2026 von Dr. Michael Peichl

Agent Engineering statt Spielerei: Der Weg zu sicheren KI-Anwendungen mit Mosaic AI

Die erste Begegnung mit generativer KI verläuft in Unternehmen meist nach dem gleichen Muster. Auf die anfängliche Faszination über die eloquente Sprachfähigkeit von Modellen wie ChatGPT folgt im geschäftlichen Kontext schnell die Ernüchterung. Werden komplexe technische Fragen gestellt, lautet das Urteil der Fachbereiche oft: „Das klingt gut, ist inhaltlich aber nicht belastbar.“

Genau an diesem Punkt stagniert die Adaption in vielen deutschen Unternehmen. Sie stecken in der Pilotphase fest. Es gibt zahlreiche Experimente, aber kaum produktive Anwendungen. Der Grund ist simpel: Im deutschen Mittelstand ist Verlässlichkeit unverhandelbar. Wenn ein KI-System falsche Wartungsintervalle ausgibt oder Ersatzteile „halluziniert”, entstehen operative und rechtliche Risiken, die kein Management eingehen kann.

Der Standortvorteil: Innovation im europäischen Rechtsrahmen

Der Zeitpunkt für die Skalierung ist dabei sowohl technologisch als auch strategisch ideal. Digitale Souveränität ist kein bloßes Schlagwort mehr, sondern lässt sich architektonisch umsetzen. Durch moderne Plattformen verbleiben Daten physisch in EU-Regionen, während zentrale Governance-Schichten die Compliance (etwa im Hinblick auf NIS-2 oder den EU AI Act) nicht erst am Ende prüfen, sondern technisch erzwingen). Dies ermöglicht von Beginn an rechtssichere Innovationen – ein Thema, das wir im Security-Deep-Dive bereits beleuchtet haben.

Das Missverständnis: Eloquenz ist nicht gleich Kompetenz

Um verlässliche Agenten zu entwickeln, muss die Funktionsweise von Large Language Models (LLMs) entmystifiziert werden. Diese Modelle sind statistische Maschinen und keine Wissensdatenbanken. Sie optimieren lediglich die Wahrscheinlichkeit des nächsten Wortes. Dadurch sind sie auch dazu in der Lage, faktisch falsche Aussagen mit hoher Überzeugungskraft zu formulieren.

Man kann sich das Modell wie einen Theoretiker vorstellen, der sämtliche Handbücher auswendig gelernt hat, aber nie selbst an der Maschine gearbeitet hat. Fehlt ihm das spezifische Kontextwissen zu einem akuten Problem, improvisiert er. Das bedeutet jedoch nicht, dass die Technologie unbrauchbar ist. Es bedeutet lediglich, dass wir KI-Systeme technisch „führen“ müssen – durch validierte Daten, klare Leitplanken und kontinuierliche Qualitätsprüfung.

Hinweis: Wer sich tiefer mit dem organisatorischen Spannungsfeld zwischen der Autonomie von KI-Agenten und notwendigen Kontrollmechanismen beschäftigen möchte, dem empfehle ich ergänzend den Beitrag meiner Kollegin und meines Kollegen „Agentic AI: Effizienzgewinne, Autonomie & Fragen zur Kontrolle“.

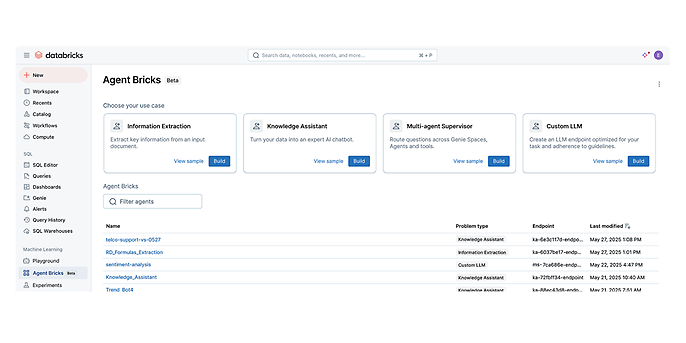

Praxis-Check: Vom Chatbot zum Prozess-Agenten

Die technische Antwort auf das Halluzinationsproblem ist RAG (Retrieval Augmented Generation). Dabei wird das Modell dazu gezwungen, Antworten ausschließlich auf Basis bereitgestellter Unternehmensdokumente zu generieren. Mit dem Mosaic AI Agent Framework und den Agent Bricks von Databricks wird dieser Prozess standardisiert. Agent Bricks beschleunigt die Entwicklung durch vorgefertigte und evaluierte Muster.

Drei Szenarien liefern erfahrungsgemäß schnell messbaren Nutzen:

1. Der Knowledge Assistant (Der Experte)

Statt Dokumente manuell zu durchsuchen, fragt das Wartungsteam: „Wie wird Modul X laut Handbuch 2024 kalibriert?“ Der Agent liefert die Antwort inklusive Quellenverweis auf Seite und Absatz. Dies reduziert Suchzeiten massiv. Voraussetzung sind jedoch sauber aufbereitete Daten und strikte Zugriffskontrollen.

2. Der Information Extraction Agent (Der Sachbearbeiter)

Hier findet kein Dialog statt. Der Agent verarbeitet unstrukturierte Eingänge wie Rechnungen oder Verträge im Hintergrund und überführt relevante Fakten in strukturierte Tabellen. Das Ergebnis ist ein automatisierter Prüfpfad, der manuelle Datenerfassung ablöst.

3. Der Supervisor Agent (Der Manager)

In sogenannten „Compound AI Systems“ (The Shift from Models to Compound AI Systems – The Berkeley Artificial Intelligence Research Blog) delegiert ein übergeordneter Agent Aufgaben. Ein Kundenanliegen wird analysiert und an spezialisierte Tools verteilt (etwa Adressdaten aus dem CRM, Konditionen aus SAP). In kritischen Bereichen entscheidet der Agent nicht final, sondern bereitet Entscheidungen für den Menschen vor (Human-in-the-Loop).

Quelle: Agent Bricks Agent Bricks | Databricks

Qualitätssicherung als Engineering-Disziplin

Ein Chatbot, der bei fünf Testfragen gut funktioniert, ist noch lange nicht produktionsreif. Wie verhält sich das System bei hunderten gleichzeitigen Anfragen und seltenen Randfällen? Im professionellen Software Engineering ist Hoffnung keine Strategie.

Wir etablieren daher drei Sicherheitsnetze in der Architektur:

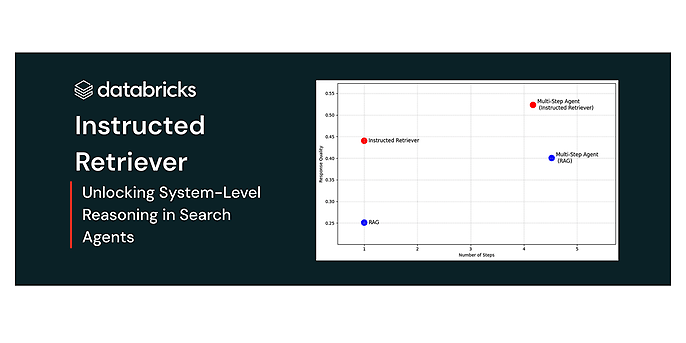

- 1. Präzises Retrieval (Instructed Retriever & Hybrid Search (Instructed Retriever: Unlocking System-Level Reasoning in Search Agents | Databricks Blog):

Die reine Vektorsuche ist oft zu ungenau für technische Details. Sucht eine Fachkraft nach Artikelnummer „X-900“, ist ein semantisch ähnliches Dokument zu „X-800“ nutzlos. Databricks kombiniert daher die klassische Stichwortsuche (für harte Fakten) mit der Vektorsuche (für den Kontext). Der Instructed Retriever versteht die Suchintention besser, während ein Reranking-Modell die Treffer vor der Antwortgenerierung nochmals filtert.

- 2. Automatisierte Evaluation (Mosaic AI Agent Evaluation (Introducing Enhanced Agent Evaluation | Databricks Blog):

Wir deployen keinen Code ohne Unit-Tests – das muss auch für KI gelten. Mit der Agent Evaluation lassen wir das System gegen einen definierten Testdatensatz (Golden Set) laufen. Ein „LLM-as-a-Judge“ bewertet die Antworten automatisiert nach Kriterien wie Korrektheit und Quellenbezug. So erhalten wir objektive Qualitätskennzahlen statt subjektiver Einschätzungen.

3. Aktualität durch Vector Search:

Veraltetes Wissen ist ein Risiko. Ändern sich Dokumente oder Preise, muss der Agent dies sofort wissen. Mosaic AI Vector Search (Mosaic AI Vector Search | Databricks on AWS) nutzt Delta Sync, um den Suchindex automatisch aktuell zu halten, sobald sich die zugrundeliegenden Daten im Lakehouse ändern.

Quelle: Instructed Retriever: Unlocking System-Level Reasoning in Search Agents | Databricks Blog

Strategische Unabhängigkeit: Open Source First

Viele Unternehmen machen sich derzeit stark von den Modellen einzelner US-Anbieter abhängig. Das birgt Risiken bei Preisen, Verfügbarkeit und Datenschutz. Databricks ermöglicht mit Mosaic AI einen „Open Source First“-Ansatz (beispielsweise mit Llama 3 oder DBRX).

Das bietet euch drei Vorteile:

- Datenschutz: Die Inferenz läuft in eurer eigenen Cloud-Umgebung, keine Daten verlassen euren kontrollierten Bereich (https://www.databricks.com/product/machine-learning/mosaic-ai-training: sicher und regelkonform).

- Anpassbarkeit: Mit Mosaic AI Model Training (https://www.databricks.com/product/machine-learning/mosaic-ai-training) können offene Modelle mit eigener Unternehmensterminologie nachtrainiert (Fine-Tuning) werden, was die Präzision oft kostengünstiger steigert als riesige generische Modelle .

- Kontrolle: Ihr behaltet die Hoheit über das „Gehirn“ eurer Anwendung.

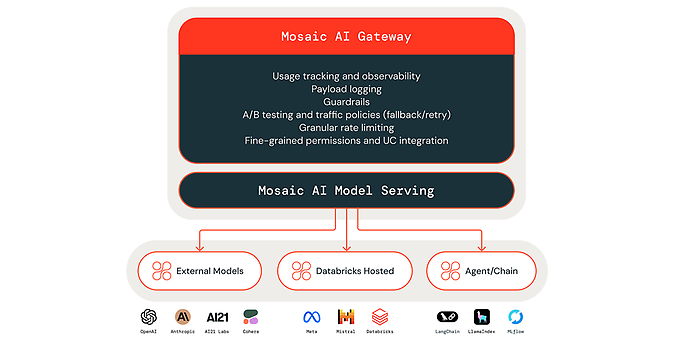

Das Gateway als Governance-Firewall

Technisch wird der Zugriff über das Mosaic AI Gateway (https://www.databricks.com/blog/new-updates-mosaic-ai-gateway-bring-security-and-governance-genai-models) gesteuert. Es fungiert als zentrale Schnittstelle, die alle Anfragen an Modelle überwacht. Hier werden Richtlinien für Rate Limiting, Zugriffskontrolle und das Filtern sensibler Daten (PII) durchgesetzt. Im Hinblick auf Regulatorik wie den EU AI Act ist diese zentrale Protokollierung und Steuerung essenziell

Quelle: Mosaic AI Gateway https://www.databricks.com/blog/new-updates-mosaic-ai-gateway-bring-security-and-governance-genai-models

Fazit: Raus aus dem Labor

Wir befinden uns an einem Wendepunkt. Die Technologie ist reif für den produktiven Einsatz. Die Herausforderung liegt nicht mehr in der Machbarkeit, sondern in der sauberen Integration in bestehende Prozesse und der Sicherstellung von Governance. Mit dem Mosaic AI Agent Framework und offenen Modellen verwandeln wir Daten von einem passiven Archiv in aktives Wissen.

Doch Vorsicht: Wer viele Agenten baut, hat bald viele Datenpipelines. Wie ihr diesen neuen Werkzeugkasten wartbar haltet, beleuchten wir im nächsten Artikel.

Eure KI, eure Regeln

Habt ihr genug von Proof-of-Concepts, die nicht skalieren? Wir bei adesso unterstützen euch dabei, den Schritt vom Labor in die produktive Wertschöpfung zu gehen. Wir realisieren RAG-Systeme auf Basis offener Standards – sicher, messbar und wertstiftend.