1. Juli 2025 von Jan Skrovanek

Warum der Umstieg auf souveräne GenAI einfacher ist, als gedacht

Was steckt hinter dem Begriff von „Souveräner KI“?

Künstliche Intelligenz (KI) verändert unsere Geschäftswelt fundamental. Doch während Unternehmen die Potenziale von KI erschließen möchten, wächst gleichzeitig das Bewusstsein für die Risiken externer Abhängigkeiten.

Viele Unternehmen verfügen über keine eigenen Kompetenzen in Schlüsseltechnologien wie KI. Dadurch sind sie abhängig von großen Technologieunternehmen, was ein strategisches Risiko darstellen kann. Auf der anderen Seite steht der Bedarf, leistungsstarke Technologie nutzen zu müssen, um mit dem Wandel Schritt zu halten. Moderne Large Language Models (LLMs) sind sehr aufwändig und kostenintensiv im Training und Betrieb, sodass eine komplett autonome KI-Infrastruktur für den Großteil der Unternehmen nicht in Frage kommt.

Der Begriff „Souveräne KI" beschreibt die Balance zwischen diesen beiden Extremen. Es geht um die Fähigkeit von Unternehmen, KI-Technologien selbstbestimmt, sicher und unter eigener Kontrolle zu nutzen – ohne dabei kritische Geschäftsdaten oder Entscheidungsprozesse in fremde Hände zu geben. Den Wunsch nach Alternativen zeigt auch unser GenAI Impact Report Germany 2025, wo 71 Prozent der Befragten angeben, dass es ihnen wichtig oder sehr wichtig ist, dass die GenAI-Anwendungen für ihr Unternehmen in Europa entwickelt wurden.

Was viele falsch verstehen: Ein Wandel in Richtung souveräne KI bedeutet keinen radikalen Bruch, sondern einen schrittweisen Übergang in ein neues Betriebsmodell. Das ist überall dort wichtig, wo Unternehmen ihre digitale Unabhängigkeit bewahren wollen oder müssen. Souveränität bedeutet jedoch nicht, sich vollständig von den großen Anbietern abzuwenden, denn das ist unrealistisch. Vielmehr geht es um die Freiheit, selbst zu entscheiden, wie der eigene GenAI-Stack aussieht und flexibel genug zu bleiben, um auf geopolitsche Risiken reagieren zu können.

Wie fängt man am besten an?

Um den ersten Schritt in Richtung souveräne KI zu machen, sollte eine kurze Bestandsaufnahme der verfügbaren Komponenten in einem GenAI-Stack gemacht werden.

Der Wechsel auf „souveräne Lösungen“ wird oft mit Einbußen in der Leistungsfähigkeit in Verbindung gebracht. Aber ist das gerechtfertigt? Oder lässt sich souveräne KI so gestalten, dass man die Leistung der führenden Anbieter matchen kann?

Für eine solche Analyse muss zunächst definiert werden, welche Komponenten zu einer „GenAI-Lösung“ gehören. Grob lässt sich das in drei Bereiche aufteilen:

- 1. Hardware & Infrastruktur

- 2. Sprachmodelle

- 3. Software

In diesem Blog-Beitrag werfe ich einen kurzen Blick auf diese drei Ebenen und beantworte die Frage: „Können souveräne Lösungen mit der Leistungsfähigkeit der Marktführer mithalten?“.

Hardware – kaufen, mieten oder beides?

LLMs brauchen bekanntlich hohe Rechenkapazitäten – sowohl beim Training als auch bei der Inferenz. Am besten geeignet sind hierfür spezialisierte GPUs, die aufgrund ihrer Fähigkeit zu parallelen Rechenoperationen besonders gut für das Betreiben von KI-Modellen optimiert sind.

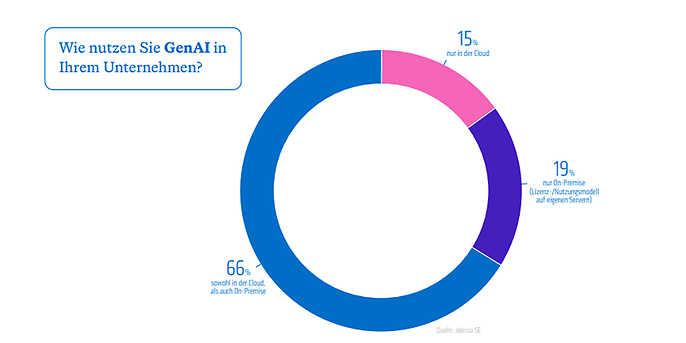

Wir haben im Rahmen unseres GenAI Impact Reports Germany 2025 gefragt, wo Unternehmen ihre GenAI-Anwendungen hosten. Hier kam heraus, dass 66 Prozent der Unternehmen einen hybriden Ansatz haben – sie nutzen also sowohl die Cloud als auch eigene On-Premise Infrastruktur.

Die US-Hyperscaler sind unerreicht, wenn es um Skalierung und Kapazitäten geht. Allein dieses Jahr planen Google, Microsoft und Amazon circa 250 Milliarden US-Dollar in Datencenter zu investieren. Die schiere Rechenleistung der großen Cloud-Anbieter wird dazu noch ergänzt durch einen Software-Stack und ein Ökosystem, das seit vielen Jahren gewachsen ist. Das macht die Cloud-Anbieter zu einer attraktiven Option für verschiedenste Unternehmen – und das wird auch auf absehbare Zeit so bleiben.

Auf der anderen Seite steht der Ausbau von On-Premise-Kapazitäten. Moderne State-of-the-Art GPUs sind nicht billig – eine einzelne Grafikkarte des neuesten Typs „GB200“ von NVIDIA aus der Blackwell Serie kostet bis zu 70.000 US-Dollar. Ein einzelnes Server Rack bestehend aus 8 GPUs kostet ca. eine halbe Million. Dazu kommen Kosten für die Wartung der Infrastruktur, welche die Total Cost of Ownership (TCO) negativ beeinflussen. Das soll nicht heißen, dass jeder der On-Premise LLMs nutzen will, direkt eine halbe Million in GPUs investieren muss – einige schlanke Modelle laufen schon heute auf Endgeräten wie Laptops. On-Premise wird ebenso wie die Cloud immer eine Daseinsberechtigung haben, insbesondere wenn es um schützenswerte, sensible Daten geht.

Ein Mittelweg aus den beiden Optionen bieten sogenannte Sovereign-Cloud-Angebote. Hierzu können sowohl europäische Hyperscaler (unter anderem StackIT oder IONOS) als auch spezielle Angebote der US-Hyperscaler (zum Beispiel AWS Sovereign Cloud oderGoogle Sovereign Cloud). Der Funktionsumfang und die Kapazität steigt hier stetig an, sodass diese Anbieter für mehr Workloads eine starke Option darstellen.

Die Frage für die Zukunft lautet daher: Welche Workloads können in der Cloud laufen und welche Workloads sind aufgrund ihrer Sensibilität möglicherweise besser in On-Premise Umgebungen oder in einer souveränen Cloud aufgehoben?

Insgesamt lässt sich sagen, dass die Hardware stellenweise noch ein Bottleneck darstellen kann. Auch wenn die Diskussion oft als „Cloud oder On-Premise“ dargestellt wird zeigt die Realität, dass die meisten Unternehmen bereits hybride Ansätze verfolgen. Ein pragmatischer Blick auf die KI-Workloads im Unternehmen mit einer Betrachtung des Skalierungsbedarfs, der Funktionsanforderungen und der Sensibilität der Daten kann dabei helfen zu entscheiden, welche Workloads in welchem Betriebsmodell laufen. Die TCO sollte dabei auch berücksichtigt werden, da die Hyperscaler aufgrund ihrer Skaleneffekte teilweise attraktivere Konditionen anbieten können.

Webinar on-demand

Zukunftssicher mit souveräner KI

Warum KI-Souveränität jetzt zählt – und wie der Einstieg gelingt, ohne strategische Risiken einzugehen. Erfahren Sie im Webinar, worauf es ankommt und wie technologische Eigenständigkeit wirklich gelingt.

Sprachmodelle im Fokus – kann Open-Source mit OpenAI und Co. Mithalten?

Das „Gehirn“ jeder GenAI-Lösung sind LLMs. Diese Modelle werden auf riesigen Datenmengen trainiert, die in etwa 10 Billionen Worten entsprechen, wie beispielsweise Trainingssätze von Internetseiten (CommonCrawl, RefinedWeb), Social Media Plattformen (YouTube, Reddit) oder Datensätzen bestehend aus Büchern und öffentlichen Datenbanken. Die gewaltigen Datenmengen werden mit verschiedenen Mechanismen kombiniert, um die Sprachverarbeitung zu optimieren (zum Beispiel Transformer-Architekturen und Attention-Mechanismen). Dies macht LLMs zu einem mächtigen Werkzeug in verschiedenen Anwendungsbereichen - beispielsweise Chatbots, bei der Informationsextraktion aus Dokumenten oder bei Übersetzungen. Sogenannte „multimodale“ LLMs sind darüber hinaus in der Lage, verschiedene Formate als Input und Output zu nutzen, wie beispielsweise Audio, Video und Bild.

Grundsätzlich kann zwischen proprietären und Open-Source-Modellen unterschieden werden. Während proprietäre Modelle (zum Beispiel OpenAI GPT-o3 oder Google Gemini 2.5 Pro) nur in den Umgebungen der Hersteller oder per API verwendet werden können, sind Open-Source Modelle frei verfügbar.

Über die letzten Jahre hat sich Open-Source Community für KI-Modelle rasant entwickelt. Anfang 2022 konnte man auf Hugging Face (eine Plattform für Open-Source KI-Modelle) noch ca. 25.000 KI-Modelle finden. Heute liegt diese Zahl bei über 1.800.000. Allein die Llama-Modelle von Meta wurden bereits mehr als eine Milliarde mal heruntergeladen.

Bei Betrachtung von gängigen Benchmarks entsteht der Eindruck, dass die besten Modelle aus geschlossenen Systemen kommen. Gemini 2.5 Pro von Google oder o3 von OpenAI dominieren die Benchmarks, doch der Vorsprung der führenden KI-Labore schrumpft. Während der Vorsprung 2023 und 2024 noch uneinholbar wirkte, schaffen es Anbieter von Open-Source-Modellen wie Meta, Mistral oder Deepseek, Modelle zu entwickeln, die die Leistung der Marktführer zu 95 Prozent matchen. Sechs der 20 führenden Modelle in der LMArena sind inzwischen Open-Source. Der Trend ist klar: Der Vorsprung schmilzt und die Innovationsfortschritte (zum Beispiel reasoning, long context oder MoE-Architekturen) sind in der Regel nach ein paar Monaten auch in Open-Source-Modellen zu finden.

Dazu kommt, dass die pure „Intelligenz“ des Modells nicht der einzige Faktor für die Leistung im Business-Kontext ist. Die Anreicherung des Modells mit relevanten, domänenspezifischen Daten, etwaiges Finetuning, cleveres Prompt Engineering und eine intelligente Verzahnung verschiedener Modelle haben ebenso die Möglichkeit, die Leistungsfähigkeit positiv zu beeinflussen.

Zusammengefasst kann man sagen, dass Open-Source LLMs heute eine valide Alternative zu geschlossenen Systemen darstellen und absolut ausreichend für ein breites Spektrum an Use Cases sind.

Der Software-Stack

Sobald die benötigte Hardware vorhanden ist und die Sprachmodelle ausgewählt wurden fehlt noch ein letztes Puzzlestück – die Software, um alles zusammenzubringen und eine Lösung aufzubauen. Die Anforderungen an einen Software-Stack für GenAI-Lösungen sind umfassend, insbesondere für den produktiven Einsatz. Einige der wichtigsten Tools beinhalten:

- Data Storage: Bereitstellung von Lösungen zur Datenspeicherung, wie Vektordatenbanken oder Knowledge Graphs.

- LLM-Observability: Je komplexer KI-Lösungen werden, desto wichtiger sind Tools, um das Verhalten zu überblicken und analysieren.

- LLM-Evaluation: Gezielte Methoden zur Auswertung der Leistungsfähigkeit von verschiedenen Konfigurationen.

- LLM-Orchestration und Routing: Aufbau von komplexen Workflows und Routing-Systemen.

- Security Tools: Schutz vor Angriffen und Aufbau von stabilen Guardrails.

- Memory Management: Optimierte Verwaltung des „Gedächnisses“ der Lösung, um die Performance über Zeit zu verbessern.

- Communication Protocols: Standardisierte Kommunikationsprotokolle, wie beispielsweise MCP oder A2A.

- Use Case spezifische KI-Lösungen: Bestimmte Lösungen für einen konkreten Anwendungsfall.

Die Entscheidung für einen Software-Stack hängt eng mit den anderen beiden Komponenten zusammen. So bieten die Hyperscaler eigene Lösung in ihren Cloud-Umgebungen an (zum Beispiel VertexAI in der Google Cloud oder Azure OpenAI von Microsoft). Diese Tools bieten einen breiten Leistungsumfang, sind jedoch nur mit der jeweiligen Cloud-Umgebung des Anbieters kompatibel.

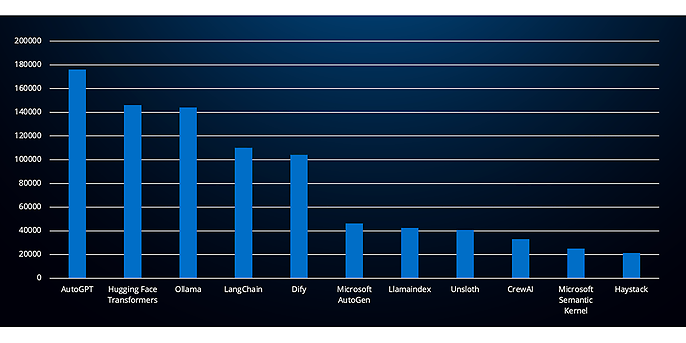

Eine Entwicklung, von der souveräne Lösungsansätze stark profitieren, ist die starke Open-Source Community, die im Bereich von KI-Entwicklungstools gewachsen ist. Tools wie LangChain, Ollama und Llamaindex sind alle als Open-Source Frameworks verfügbar und bilden in vielen Projekten die Grundlage für die Implementierung von GenAI-Lösungen. Fünf Open-Source Tools haben sogar mehr als 100.000 Sterne auf GitHub erreicht, was ihre breite Akzeptanz verdeutlicht (AutoGPT, Hugging Face Transformers, Ollama, LangChain, Dify).

Open Source Frameworks nach GitHub Stars

Ein potenzieller Nachteil von Open-Source Lösungen im Vergleich mit geschlossenen Systemen sind fehlende Enterprise-Funktionalitäten, insbesondere wenn es um Themen wie Skalierung und Sicherheit geht. Darüber hinaus sind die Optionen für Managed Services und Support deutlich eingeschränkter.

Insgesamt lässt sich sagen, dass Open-Source Frameworks einen festen Platz in der Entwicklungsebene von GenAI-Lösungen haben und es bereits viele etablierte Anbieter gibt, die produktiv im Einsatz sind. Um die erhöhten Sicherheits- und Skalierungsanforderungen von Enterprise-Architekturen zu treffen ist jedoch ein Investment in Entwicklungskompetenz dringend notwendig. Erfahrene Entwicklerinnen und Entwickler können die Unabhängigkeit und Flexibilität von Open-Source Lösungen nutzen und in einen sicheren, souveränen Software-Stack überführen. So lässt sich ein souveräner Software-Stack aufbauen, der absolut wettbewerbsfähig ist und für den Einsatz im Enterprise-Kontext ausgelegt ist. Am Ende kommt es also auf menschliche Kompetenz an.

Fazit zur Wettbewerbsfähigkeit

Zusammenfassend lässt sich sagen, dass souveräne Ansätze stark von der Open-Source Bewegung im KI-Bereich profitieren. LLMs sowie Software sind inzwischen sehr leistungsfähig als Open-Source-Komponenten verfügbar. Die Entwicklung der letzten 12 Monate zeigt darüber hinaus, dass die Lücke zwischen Open-Source und geschlossenen Systemen kleiner wird oder ganz verschwindet. Somit kann man sich sicher sein, dass man mit einem Open-Source Stack in den Bereichen der Software und der Sprachmodelle zukunftsfähig aufgestellt ist.

Die Hardware muss differenziert betrachtet werden. Die Angebote von souveränen Cloud-Lösungen nehmen stark zu und werden in den nächsten Jahren an Kapazität und Leistung dazugewinnen. Dennoch sind die US-Hyperscaler immer noch das Maß aller Dinge, wenn es um Skalierfähigkeit von Workloads geht. Es sollte daher genau betrachtet werden, welche Prozesse auf absehbare Zeit bei den Hyperscalern bleiben werden und welche (aufgrund von geringerem Volumen oder höheren Anforderungen an Privacy) in eine souveräne Cloud oder eine On-Premise Instanz gehören.

Was sollten Unternehmen jetzt tun?

Die Wettbewerbsfähigkeit von souveränen Lösungen wird allgemein unterschätzt – aber was bedeutet das für Unternehmen und sollte jetzt getan werden?

- 1. Eine genau Analyse des eigenen GenAI-Stacks sollte gemacht werden. Der Fokus sollte hier auf einer Prüfung des Einsatzes von souveränen und Open-Source Komponenten liegen.

- 2. Die bestehenden und geplanten KI-Workloads sollten basierend auf ihren Anforderungen den verschiedenen Hosting-Optionen (Hyperscaler, Souveräne Cloud, On-Premise) zu geordnet werden.

adesso unterstützt euch auf eurem Weg zur souveränen KI. Mit über 100 erfolgreich abgeschlossenen GenAI-Projekten bringen wir das notwendige Know-How mit und wissen, was es braucht, um GenAI auf die Straße zu bringen.

Wir unterstützen euch!

Seid ihr bereit für den nächsten Schritt zur souveränen KI? Dann sprecht uns an, wenn ihr Interesse an einem GenAI Readiness Review oder einem Implementierungsangebot habt. Unsere Fachleute unterstützen euch.