12. Juli 2022 von Lilian Do Khac

Trustworthy AI – eine wilde Spannung zwischen Mensch und Maschine Interaktion

Künstliche Intelligenz (KI) entwickelt sich kontinuierlich weiter und die Grenzen des Status quo der Machbarkeit werden Schlag um Schlag eingeholt. Auf Managementebene stellt sich zunehmend die Frage, wie diesen Herausforderungen im Unternehmen begegnet werden soll. In den letzten 50 Jahren wurde die Mensch-und-Maschine-Kollaboration mehr aus einer technischen Sicht getrieben als auf Basis von formalisierten sozialen Anforderungen. Für diese konkrete Herausforderung gibt es verschiedene Bezeichnungen wie „Soziotechnisches System“, „Mensch-und-Maschine-Interaktion oder -Kollaboration“, „Trust AI“ und „Trustworthy AI“. Der kleinste gemeinsame Nenner stellt dabei die Bestrebung nach ökonomisch sinnvoller sowie sozial und ökologisch vertretbarer Integration in die bestehenden Abläufe dar.

Im Auftakttreffen des National Artificial Intelligence Advisory Committees (NAIAC) der Vereinigten Staaten am 4. März 2020 bringt Dr. Alondra Nelson, Leiterin des White House Office of Science and Technology Policy (OSTP), es auf den Punkt: “[…] we need to ensure that we harness the good of AI and banish the bad […].” Nachdem ich im ersten Blog-Beitrag dieser Reihe aus einer Vogelperspektive das ganzheitliche Gerüst von Trustworthy AI thematisiert habe, möchte ich nun tiefer mit euch einsteigen. In diesem Beitrag werfe ich einen Blick auf die Kernanforderung im Trustworthy-AI-Bereich, nämlich „Vertrauen“. Zudem werde ich auch Aspekte hinsichtlich der Arbeitsteilung zwischen Mensch und Maschine elaborieren.

Wie es von der maschinengetriebenen industriellen Revolution immer mehr in die kognitiv getriebene soziale Revolution geht

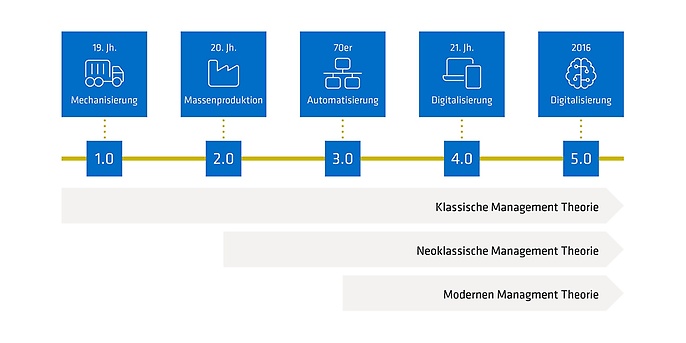

Um zu verstehen, worum es im Kern bei den aktuellen Herausforderungen der Mensch-und-Maschine-Interkation geht, muss man sich zunächst klarmachen, woher die Herausforderungen kommen, beziehungsweise verstehen, was das „Legacy“ dahinter eigentlich. ist. Eine kurze Zusammenfassung der verschiedenen industriellen Revolutionen bringt Licht ins Dunkel: Bis zum Ende des 19. Jahrhunderts ermöglichte die Mechanisierung den Anfang vom industriellen Wandel (Industrie 1.0), von kleineren Farmen zu größeren Fabriken, von kleinen Lebensmittelläden zu standardisierten Unternehmen. Die zweite industrielle Welle (Industrie 2.0) schloss daran an und ermöglichte weiter die Massenproduktion von Gütern. Damit einhergehend entwickelten sich Fragestellungen, wie große Gruppen von Menschen entlang der Arbeit mit Maschinen organisiert werden sollen. Erste Ansätze der klassischen Managementtheorie, die noch bis heute nachhallen, entstanden dabei – prominente Vertreter sind Frederick Taylor, Henri Fayol und Max Weber. Diese Ansätze wurden in der dritten industriellen Revolution (Industrie 3.0) durch Automatisierung weitergetrieben. Ein wesentliches Entwicklungsmerkmal spiegelt sich hier jedoch bei der Betrachtung des sozialen Aspektes in der organisatorischen Struktur wider. So wurde der Mensch vielmehr zur Operatorin beziehungsweise zum Operator der Maschinen und Fragestellungen hinsichtlich Monitoring-Instrumenten. Soziologische und psychologische Aspekte – wesentliche Aspekte der neoklassischen Managementtheorie – traten mehr in den Vordergrund. Das Stichwort in diesem Zusammenhang sind die Hawthorne-Experimente, die die Produktivitätsförderung durch Gestaltung der unmittelbaren Arbeitsumgebung als Untersuchungsgegenstand hatten.

Der Begriff „Automatisierung“ wurde nebenbei im Übrigen für den Sprachgebrauch initialisiert. Nicht mal ein halbes Jahrhundert später sind wir da angekommen, wo wir gerade sind. Nämlich in der vierten industriellen Revolution (Industrie 4.0) oder anders bezeichnet „dem digitalen Zeitalter“ und der verstärkten Entwicklung von modernen Managementtheorien. Moderne Managementtheorien sind ungefähr das, was nicht klassische Managementtheorie ist. Hier wird vielmehr analytisch und datengetrieben gearbeitet. Denn nun ist der Zugriff möglich und quantitative Eigenschaften sowie eine verstärkte Betrachtung auf komplexe Zusammenhänge im Detail mit systemtheoretischen Ansätzen entsprechen dem vorherrschenden Ansatz. Ist in den vorherigen industriellen Revolutionen vorwiegend das Einzelne in das große Ganze aufgegangen, so tritt das einzelne Individuum nun wieder in den Vordergrund und wird zum Zentrum der Anforderung – es wird also mehr menschenzentriert. Das technische Gefüge verschmilzt vielmehr in das soziale Gefüge und führt so zur Mensch-und-Maschine-Kollaboration – Achtung! Kollaboration ist nicht Kooperation. Der Aspekt „Vertrauen“ ist die kognitive Brücke, die für solch eine erfolgreiche Kollaboration geschlagen werden muss und die Herausforderung der kommenden Jahrzehnte darstellt. Einige Wissenschaftler, vornehmlich aus den Forschungszweigen rund um die Entscheidungstheorie – unter anderem Operations Research – bezeichnen diese Entwicklung unter anderem als Industrie 5.0.

Vertrauen: Ein romantischer Anklang aus zwei Perspektiven

Die Anwendung von KI-Applikationen hat signifikante Implikationen auf der Managementdimension und sollte nach Sebastian Raisch und Sebastian Krakowski mehr als „[…] eine neue Klasse von Akteuren in der Organisation […]“ aufgefasst werden. Dem Duden zufolge ist ein Tool definiert als ein „für bestimmte Zwecke geformter Gegenstand, mit dessen Hilfe etwas [handwerklich] bearbeitet oder hergestellt wird“. Im Gegenzug definiert der Duden den Begriff Akteurin oder Akteur als „Handelnde[/]r, an einem bestimmten Geschehen Beteiligte[/]r; handelnde männliche [oder diverse] Person“. Eine Akteurin beziehungsweise ein Akteur bezeichnet also etwas, was sich selbst durch Lernen verbessern kann.

Mitte der 1990er Jahre bildeten sich zwei wesentliche formale Vertrauensmodelle aus zwei verschiedenen Forschungsrichtungen heraus. Die eine entstammte den Forschungen aus den Sozialwissenschaften mit dem Anspruch, ein besseres Verständnis über die zwischenmenschliche Zusammenarbeit in komplexen Organisationsstrukturen zu erklären. Die andere entstammte den Forschungen aus der Automatisierungswissenschaft mit dem Anspruch, die Mensch-und-Automatisierungs-Interaktion besser zu verstehen und somit die Hervorhebung von spezifischen Eigenschaften der eingesetzten Technologie. Die sozialwissenschaftliche Forschung betrachtet Akteurinnen und Akteure und sieht Vertrauen durch zwischenpersönliche Charakteristiken moderiert (Kompetenzen der KI, Integrität der KI und Wohlwollen der KI). Die Automatisierungswissenschaft hingegen stellt die Betrachtung mittels Charakteristiken der Automatisierung in den Vordergrund (Grund für die KI, Prozess, in dem die KI eingebettet ist, und die KI-Performanz).

Im Spannungsfeld des Kollaborations-Paradoxons

In meinem letzten Blog-Beitrag zum Thema Trustworthy AI habe ich das durch KI bedingte Managementproblem kurz beschrieben. Dabei ging es darum, dass die KI-Fähigkeiten sich stetig weiterentwickeln und somit die Mensch-und-KI-Kollaboration einer ständigen Rekalibrierung unterliegt. In ihrem eindrucksvollen Artikel „Artificial Intelligence and Management: The Automation-Augmentation Paradox“ schildern Sebastian Raisch und Sebastian Krakowski, dass die Anwendung von KI-Applikationen im Unternehmen eng mit Zeit und Raum verflochten ist und so eine paradoxe Spannung erzeugt. Augmentierung beschreibt hier die Mensch-und-KI-Kollaboration und Automatisierung die komplette Übernahme von menschlichen Tätigkeiten. Das soll nun kein Ausflug in die Science Fiction von Interstellar werden, sondern vielmehr hervorheben, was in der modernen Managementpraxis wichtig ist.

Nicht das eine oder andere – Augmentierung oder Automatisierung – sollte in der Führung betont werden. Übertreibt man mit der Automatisierung, dann wäre es fast schon eine Rückentwicklung aus industrieller Revolutionssicht. Wird zu stark augmentiert, werden vermutlich zu viele der befürchteten negativen Nebeneffekte von KI eintreten.

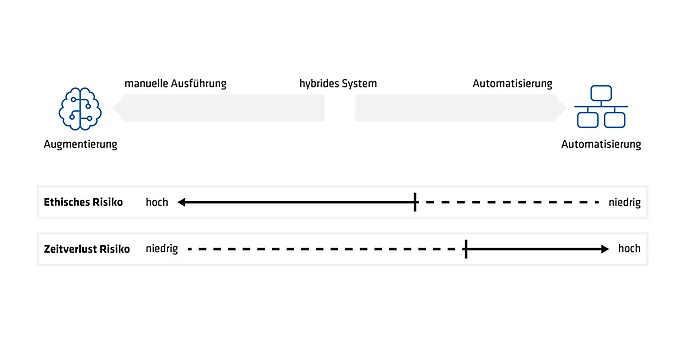

Die eben beschriebene Spannung bewegt sich zugegebenermaßen schon auf einem intergalaktischen Level. Ansätze zur Übertragung des Paradoxons auf eine operative und taktische Ebene, die zugleich als Anforderungen definiert und anschließend implementiert werden können, bezeichnet man als „adaptive Automatisierung“. Hierzu gibt es verschiedene Skalen – ausgehend von einer rein manuellen Aufgabenbearbeitung (in der folgenden Abbildung links unter „manuelle Ausführung“ zu erkennen) bis hin zu einer vollautomatisierten Aufgabenbearbeitung (rechts unter „Automatisierung“ erkennbar). Diese beiden statischen Ausprägungen sind fix und übergreifend akzeptiert. Die wesentliche Unschärfe ergibt sich im „hybriden System“. Hybrides System kann zum Beispiel bedeuten, dass eine KI die Entscheidung vorselektiert und nach menschlicher Zustimmung ausführt. Dies wäre ein sogenanntes Assistenzsystem. Ein etwas selbständigeres Hybridsystem wäre zum Beispiel ein System, das eine vorselektierte Entscheidung auch direkt umsetzt und den Menschen darüber informiert. Hier hätte der Mensch noch ein „Veto“ und könnte im „Doing“ aktiv eingreifen. Sinn und Zweck der jeweiligen statischen Interaktionsstufe ist jedoch nicht, auf dieser zu verweilen, sondern den Menschen die Möglichkeit zu schaffen, sich innerhalb der richtigen Interaktionsstufe zum richtigen Zeitpunkt angemessen zu kalibrieren. Bedingt durch die Branche und gegebenenfalls durch die konkrete Aufgabenstellung mit ihren spezifischen Anforderungen ergeben sich verschiedene Bandbreiten des möglichen Interaktionskontinuums. So könnte es in einigen Branchen oder bei konkreten Aufgabenstellungen einfach wegen der ethischen Risiken nie zu einer Vollautomatisierung kommen (siehe „Ethisches Risiko“ in der folgenden Abbildung). Eine angemessene Stufe der Augmentierung hingegen würde Potentiale maximieren. Andersherum muss sich vor Augen geführt werden, dass es Anwendungsfälle gibt, in denen das Risiko über Zeitverlust nur mit Vollautomatisierung zu schaffen ist, denn bis der Mensch eingreifen könnte, wäre es schon zu spät (siehe „Zeitverlust-Risiko“ in der folgenden Abbildung).

Die aktuelle(n) industrielle(n) Revolution(en) legt oder legen den Schwerpunkt für die nächsten Jahrzehnte ganz klar auf hybride Systeme beziehungsweise das Zusammenspiel von sozialen wie auch technischen Aspekten. Vertrauen ist das Bindeglied zwischen diesen Welten und Mittelpunkt der zukünftigen Implementierungstätigkeiten von KI in Organisationen. Das Kollaborationsparadoxon wird Fragen hinsichtlich moderner Managementparadigmen prägen und den Bedarf an besseren Kalibrierungsmechanismen zwischen Mensch und Maschine aufwerfen.

Weitere spannende Themen aus der adesso-Welt findet ihr in unseren bisher erschienenen Blog-Beiträgen.

Auch interessant:

Trustworthy AI - Das Dossier

Lassen Sie uns über Vertrauen reden

Wenn Trustworthy AI auch Ihre Aufgabenbereiche berührt, ist unser Dossier „Vertrauen lässt sich digitalisieren“ der kompakte Einstieg für Sie.