2. Juni 2022 von Lilian Do Khac

Trustworthy AI – das ganzheitliche Gerüst und was davon zukünftig geprüft wird

Im Rahmen von Trustworthy AI werden die vertrauenswürdigen Eigenschaften einer Künstlichen Intelligenz (KI) adressiert. Das Anforderungsspektrum von Trustworthy AI erstreckt sich vom Design über die Funktionen bis hin zum Betrieb der KI. Diese vertrauenswürdigen Eigenschaften sind wesentlicher Bestandteil des gesamten organisatorischen Vertrauensgerüst, um eine Mensch+KI-Kollaboration erfolgreich und nachhaltig zu gestalten. Eine nachhaltige Mensch+KI-Kollaboration bedeutet unter anderem, den regulatorischen Anforderungen gerecht zu werden. Hierzu entwickeln sich derzeit Standards, die eine Quantifizierung und somit eine Vergleichbarkeit ermöglichen. Das Themenspektrum von Trustworthy AI ist interdisziplinär und die Implikationen betreffen nahezu alle Branchen. Die Komplexität ergibt sich aus der Natur der Technologie, dem unmittelbaren Zusammenspiel mit der Umgebung und der derzeitigen Schnelllebigkeit von normativen Vorgaben. An dieser Stelle fragt man sich berechtigterweise: Wo sollen wir Anfangen und wo ist das Ende? Mit einem ganzheitlichen Framework wird eine Übersicht geschaffen, welche wiederum in kleine Teile zerlegt werden kann. Mit den einzelnen Teilen lässt sich besser arbeiten und so dann im großen Ganzen die Beherrschung von Trustworthy AI erarbeiten. Solch ein ganzheitliches Framework möchte ich gerne im Folgenden kurz vorstellen und Einzelaspekte anreißen. Ich schaue in diesem Blog-Beitrag ganz bewusst nur auf Geschäftsprozesse, denn Trustworthy AI für Produkte unterliegt einigen anderen Anforderungen und wird wahrscheinlich kein gesamtes Managementorgan benötigen zur Steuerung. Bestimmte Einzelaspekte werden in Folge-Blogs vertieft. Weiterhin werde ich das ganzheitliche Framework dem VDE SPEC 90012 V1.0 gegenüberstellen.

Warum ist KI ein „Management-Problem“?

In der Managementforschung wurde zuletzt eine KI-Definition aus Managementsicht vorgestellt. Ja, die hundertste KI-Definition, aber diese ist richtig cool! In dieser Definition wird KI als diejenige Technologiestufe definiert, die sich über den Rand, also am Bleeding-Edge, eins nach dem Cutting-Edge befindet. Wenn Cutting-Edge also der Rand des Status quo der Technologie ist, dann ist Bleeding-Edge, das was wir noch nicht können. Immer wenn wir was Neues können, dann bewegt sich dieser Rand weiter. Klingt fast wie bei Hänsel und Gretel nur ohne Ende. Dahinter steckt allerdings viel mehr. Es bedeutet, dass wir einen gelernten KI-Zustand (=Gleichgewicht), der gegebenenfalls in eine intelligente Automatisierung aufgegangen ist, nicht immer beibehalten werden, zumal sich die Welt vermutlich weiterdrehen wird und damit auch die Datenlage sich quasi weiterdreht. Wir müssen also immer wieder neu kalibrieren. Dieses oszillierende Phänomen bei der Mensch+KI-Kollaboration bedeutet, dass sich die Arbeitsteilung kontinuierlich verändert. Damit geht auch einher, dass sich Verantwortlichkeiten gegebenenfalls oszillierend verhalten. Setzt man also immer mehr KI in die bestehenden Arbeitsabläufe im Rahmen einer Mensch+KI-Kollaboration ein, um mehr Potentiale zu heben, so wird man unweigerlich auch mit dem eben beschriebenen Oszillations-Phänomen zu tun haben.

Die KI wirkt auf den Menschen ein, der Mensch auf die KI - et voilá das „Software-Tool“ wird zu einer neuen Art von Teammitglied in der Organisation. Dies impliziert einen dringenden Bedarf an ordentlicher Integration in die Arbeitsstrukturen und die Sicherstellung von ordnungsgemäßen Arbeitsabläufen - inklusive der zu erwartenden Qualität der Ergebnistypen. Die Entwicklung von KI wurde über 50 Jahre hinweg hauptsächlich aus der Techniksicht getrieben. Die sozio-technische Betrachtung ist dabei etwas hinterher geblieben. Integration bedeutet nicht nur in ein bestehendes IT-System integrieren. Die hier notwendige Integration hat auch eine signifikante organisatorische Komponente. Das Mensch+KI-System muss sich an die Marktregeln halten. In einem sozialen Kontext spielt Vertrauen eine nicht unwesentliche Rolle. In der Organisationsforschung sagt man, Vertrauen hat eine vermittelnde Rolle für die Zusammenarbeit.

Vertrauen. Klingt irgendwie romantisch, aber was ist eigentlich Vertrauen?

In der Organisationstheorie ist Vertrauen ein riesiges Thema. Wer BWL studiert hat, erinnert sich sicher an das Prinzipal-Agenten-Theorem, wo zwischen Auftraggeber (Prinzipal) und Auftragnehmer (Agent) eine Informationsasymmetrie herrscht. Diese lässt sich unter anderem durch ein Vermittlermedium, zum Beispiel einen Vertrag, hinreichend auflösen. Der Vertrag hat den Zweck, Vertrauen zu schaffen, sodass beide miteinander arbeiten können. Aus organisatorischer Sicht haben sich Hierarchie- und Managementstrukturen entwickelt, die den Zweck zur Förderung von (effizienter) Zusammenarbeit in der gesamten Organisation zum Ziel haben. Zwischen einer KI und einem Menschen wird die Vertragsschließung und Definition von Rechten und Pflichten nicht so gut funktionieren. Die KI hat keine intrinsische Motivation, sich an normative Gegebenheiten zu halten. Es sein denn diese Normative wurde explizit einprogrammiert (Kolleginnen und Kollegen, die an die harte KI glauben, werden dem wohl widersprechen. Ich bin Team weiche KI). Dazu muss es über alles „Normative“ unter uns Menschen erst einmal Konsens geben. Allein zu KI-Ethik-Leitfäden gibt es mittlerweile hunderte von verschiedenen Auffassungen.

Eine eindeutige Definition von Vertrauen gibt es nicht. Damit haben das Vertrauenskonstrukt und die KI ziemlich viele Ähnlichkeiten. Psychosomatische Faktoren sind schwer messbar (arbeitsrechtlich wäre die Messung - zum Beispiel mit Elektroenzephalografie (EEG), also neurologischen Werten, bis auf Weiteres auch nicht gestattet). KI auf schwer messbare Faktoren abzustimmen ist folglich noch schwerer. Kann man denn Vertrauen haben in eine KI oder ist das nicht nur so eine Sache zwischen Menschen (und Tieren)? In der Forschung ist man sich nicht einig. Einerseits spiegeln Menschen gegenüber Maschinen soziale Verhaltensmuster. Andererseits ist die Erwartungshaltung an die „Leistung“ der Maschine höher als gegenüber einem Mitmenschen (damals im Studium wurde „der Gerät“ als nicht schwitzend, nicht schlafend und niemals müde besungen).

Mitmenschen dürfen auch mal Fehler machen, während einer Maschine eine sehr geringe Fehlertoleranz entgegengebracht wird. So verhält es sich anschließend auch mit der Vertrauensgewinnung. Eine Maschine verliert sukzessive das Vertrauen von Menschen bei wiederkehrend auftretenden Fehlern, während Menschen mehr Vertrauen von Mitmenschen gewinnen können. Das bekannteste Vertrauenskonzept im organisatorischen Kontext stammt von R.C. Mayer und wird folglich definiert: „Trust is the willingness of a party to be vulnerable to the actions of another party based on the expectation that the other will perform a particular action important to the trustor, irrespective of the ability to monitor or control that other party.” Dazu formalisieren die Forscher drei Trustworthiness Faktoren: 1) Ability = Fähigkeiten Aufgaben abzuarbeiten oder zu lösen, 2) Benevolence = Keinen Schaden anrichten und 3) Integrity = Sich an Regeln halten. Diese Faktoren werden vermittelt durch die eigene interne Vertrauensneigung gegenüber KI und die wahrgenommene Risikosituation.

Trustworthy AI Design Elemente

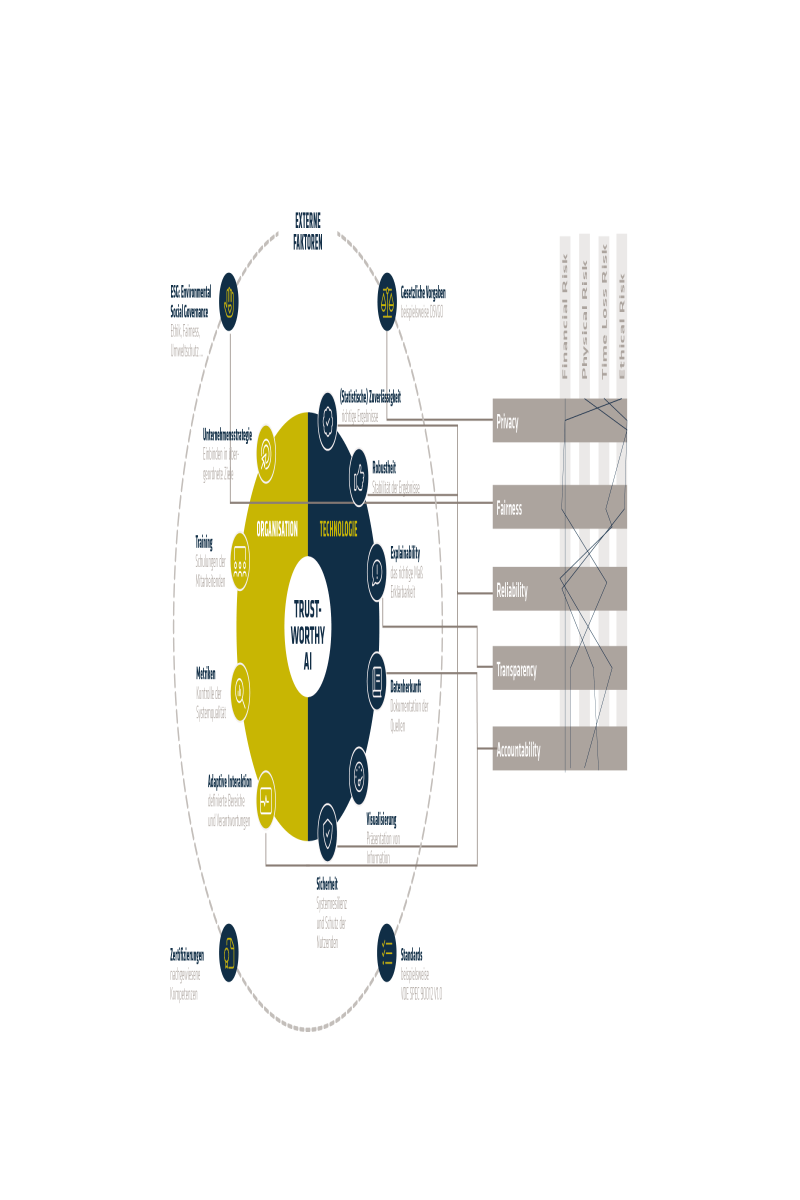

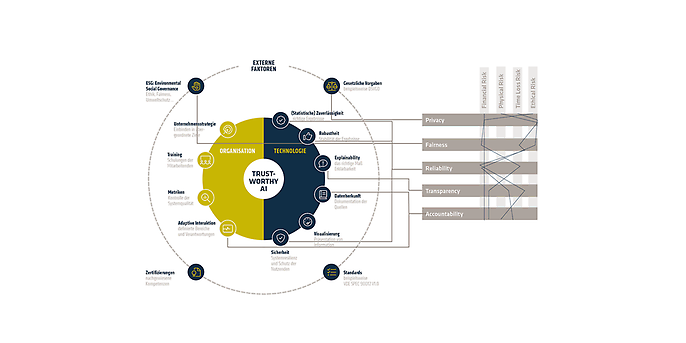

Kann man diese Trustworthiness Faktoren tiefer legen? Ja, kann man. Im Schaubild unten ist mein Verständnis und Synthese aus der Forschung und Praxis hinsichtlich Trustworthy AI zu sehen. Trustworthy-AI-Anforderungen werden demnach einerseits von technischen Funktionen realisiert und andererseits durch die Governance der Organisation (inneren Bereich der Grafik unten). Technische Funktionen sind unter anderem Zuverlässigkeit, Robustheit und Explainability (blauer Bereich in der Grafik unten). Organisatorische Funktionen sind unter anderem eine Festlegung der adaptiven Interaktionsspannen, Metriken und Trainings (gelben Bereich in der Grafik unten). Eine Organisation interagiert selbst mit ihrer Umgebung, in diesem Fall interessiert uns die Interaktion mit dem Markt. Marktregeln ergeben sich durch Regulation, durch gesetzliche Vorgaben oder auch durch Industrie-Standards. Weiterhin spielen ESG-Anforderungen eine immer wichtigere Rolle für die Akzeptanz von KI-Anwendungen. Zertifizierungen, die durch unabhängige Dritte Parteien durchgeführt werden, unterstützen Vertrauen in die KI-Anwendung. Wir versuchen im Folgenden eine Auswahl der Stichpunkte ein Level tiefer zu legen.

adesso Trustworthy AI Framework

Die technische Dimension

Die meisten technischen Anforderungen an eine vertrauenswürdige KI-Anwendung gehen dabei auf den Faktor „Ability“ ein. Dies sind zum einen Unterfaktoren wie Zuverlässigkeit, die durch Best-Practice-Software-Engineering-Methoden und die Erfüllung von Metriken aus der Statistik erfüllt werden können. Weiterhin ist Resilienz ein wesentlicher Unterfaktor. Das System muss gegenüber Umweltveränderungen und daraus resultierenden Veränderungen der Daten ordnungsgemäß funktionieren oder reagieren können. Im Fachjargon spricht man unter anderem von Drift, wozu es Detektions- und Migrationsmethoden gibt. Ein Drift ist eine Veränderung in den Daten, insbesondere hinsichtlich der Zielvariable(n) und hat damit Auswirkungen auf das Modell. Dann darf Explainability nicht vergessen werden. Nicht ohne Grund ist Explainability wohl eins der am meisten behandelten Unterkategorien, denn es liefert in nahezu jede andere Unterkategorie zu (siehe hierzu, wie der VDE SPEC 90012V.1 T3-Intelligibility vorschlägt zu bewerten). Explainability hat im kommunikationstechnischen Austausch sowie mit der gedachten Intention leider eine unglückliche Unschärfe. So wird Transparenz mit Interpretierbarkeit oder Interpretierbarkeit mit Erklärbarkeit und weiteren Synonymen vermischt. Die eigentliche Zielstellung, nämlich Erklärbarkeit gegenüber wem (Bücher und Filme haben schließlich auch ein Zielpublikum), gerät ins Vergessen. Wir unterscheiden gemäß dem Zielpublikum grob zwischen zwei Erklärbarkeitstiefen. Einmal die Transparenz, die das System ohne Retusche darstellen und somit erklärbar machen soll. Transparenz eignet sich für Developer, Data Scientists, gegeben falls auch für Auditoren, die ein Data-Science-Fachverständnis haben und die umfangreiche Prüfung oder Weiterentwicklung des Systems zur Zielstellung haben. Hierfür muss die Transparenz vollständig sein, getreu des Anwendungsfalls. Für einen Laien ist wohl ein Auszug der Transparenz der absolute Overkill. Eine Endnutzerin oder ein Endnutzer möchte gegeben falls nur verstehen, warum eine bestimmte Entscheidung (meistens die ungünstige) entstanden ist und fairerweise eine Möglichkeit haben dies anfechten zu können (zum Beispiel Kreditvergabe). Dies entspricht weniger Transparenzbedarf und vielmehr Interpretierbarkeitsbedarf. Dazu gehört klare und mundgerechte Kommunikation. Methoden wie Counterfactuals (OII | AI modelling tool developed by Oxford academics incorporated into Amazon anti-bias software) beziehungsweise „What-If“ (Was wäre, wenn durch „Ausprobieren“ von verschiedenen Eingabedaten. Siehe What-If Tool (pair-code.github.io)) Darstellung kommen dem Bedarf recht nahe. Der Blumenstrauß an Methoden im Explainable AI ist riesig und würde diesen Artikel wohl sprengen. Hierfür wird es einen weiteren Blog-Beitrag geben. Anthropomorphe Eigenschaften beziehen sich auf die Art und Weise der Kommunikationsrepräsentation von KI-Anwendungen. Unter anderem der „Avatar“ in dem sich die KI „befindet“ hat Einfluss auf die Vertrauenswürdigkeit (Stichwort: Uncanny Valley Theory. Ein Paradoxon, welches beschreibt, dass Menschen „Figuren“ weniger Vertrauen schenken, je realistischer sie versucht werden darzustellen). Grob gesehen unterscheidet man zwischen drei wesentlichen Formen. Dem Roboter, dem virtuellen Agenten (zum Beispiel die Microsoft-Büroklammer Karl Klammer) oder embedded (eher unsichtbar, beispielsweise Recommender Systeme in Netflix). Unterschieden kann man auch auf das Geschlecht (Schon mal hinterfragt, warum die Stimmen der Sprachassistenten Frauenstimmen per Default sind?). In gewissen Anwendungsszenarien sind menschenähnliche Attribute erwünscht und fördern das Vertrauen und in anderen eher nicht. Wie kann man solche Attribute nun konkret in die KI verbauen? Dazu kann beispielsweise Etiquette in der Kommunikationsausgabe untergebracht werden. Für das Thema Privacy möchte ich auf den Blog-Beitrag „Trustworthy Analytics“ von Dr. Christof Rieck und Manuel Trykar verweisen.

Die unternehmensexterne Dimension

Es gibt dazu externe Marktfaktoren, welche auf die Organisation einwirken und Rahmenbedingungen an die KI-Anwendung stellen. Erfüllt man diese Marktregeln (zum Beispiel zukünftig die Anforderungen des EU Artificial Intelligence Acts), so erfüllt man im zuvor beschriebenen Vertrauensmodell den Faktor „Integrity“. Eine klare Unterkategorie sind die ESG-Anforderungen, welche komplexe Themen wie Ethik, Fairness und Umweltschutz umfassen. Während Umweltschutz zwar komplex, aber doch noch messbar und somit gemanaged werden kann (siehe hierzu, wie der VDE SPEC 90012V.1 F3-Ecological Sustain Development vorschlägt, zu bewerten), ist das bei Ethik und Fairness nicht so einfach der Fall. Ethik ist ein kniffliges Konzept, zu dem auch allgemein kein Konsens herrscht beziehungsweise Ethik lebt und entwickelt sich weiter. Einerseits kann man sich datenseitig dem Thema annähern und an den Klassifizierungskonfiguration drehen oder Proxy Variablen zur Kontrolle formulieren und mit Data-Provenance-Methoden (Dokumentation der Datenherkunft, siehe hierzu wie der VDE SPEC 90012V.1 T1-Documentation of data sets vorschlägt zu bewerten) dokumentarisch annähern (dazu gibt es auch schon eine Handvoll Tools). Andererseits kann man sich dem auch normativ annähern und den Effekt der Entscheidung für das einzelne Datensubjekt betrachten (Counterfactuals). Nun stellt sich die Frage, wenn Ethik sich irgendwie weiterentwickelt und das neuerdings auch ganz schnell, wir uns sowieso bei einigen, wenn nicht vielen Fragestellungen noch nicht so ganz einig sind, dann kann man Ethik ja nicht einmal „reinprogrammieren“, oder? Das ist irgendwie richtig. Die Beherrschung von Ethikfragen bei der KI-Anwendung muss eine Art Governance-Funktion im Unternehmen haben und ist nicht damit bedient eine „Charta“ hinzustellen. Es reicht auch nicht einfach, einen „Chief of Ethics“ hinzustellen und bei allen Fragestellungen zu Ethik diese Person als Buh-Person zu nutzen. Das haben wir schon in der Vergangenheit gesehen. Wer ernsthaft an die Thematik ran möchte, der muss eine ernsthafte Governance-Funktion etablieren. Das klingt erstmal nach viel Arbeit und impliziert einen gewissen Zeitrahmen solche Funktionen aufzubauen. Bedeutet dies, dass man mit KI-Ethik später durchstarten würde? Keinesfalls. Es gibt sogenannte „Kindergarten Ethik“ mit der ohne Probleme schon mal angefangen werden kann. Jedem ist klar, und das wird hoffentlich keine kulturellen Unterschiede haben, ein Auto darf kein anderes Auto töten.

Die unternehmensinterne Dimension

Für die Organisation kristallisieren sich nun eine Handvoll von Maßnahmen heraus. Diese müssen neben dem Aspekt Trustworthy AI by Design in der technischen Realisierung auch organisatorische Strukturen von Management-Strategien über die KI-Anwendung spannen. Für viele Risiken bietet sich der Ansatz von adaptiver Kalibrierung an. Die Annahme ist, dass das System im Zeitverlauf, wie auch in extremeren Events, sich nicht mehr ganz perfekt verhält und der Mensch eingreifen sollte. Human-in-the-loop also, aber irgendwie adaptiv also nicht von ziemlich automatisiert zu komplett manuell. Nicht jeder kann schließlich direkt in die kalte Dusche springen. Dafür gibt es einige sogenannte Level-of-Automation-Skalen in der Wissenschaft, an denen Inspiration gefunden werden kann. Nur wann weiß der Mensch, wann er eingreifen soll? Dafür muss sich die KI irgendwie „bemerkbar“ machen. Die KI muss sich also durch eine Alarmfunktion bemerkbar machen. Jeder kennt es, je häufiger es auf alarmierende Weise piepst, desto eher wird es nicht mehr ganz ernst genommen oder man hat gar keine Lust mehr, sich damit zu befassen, weil die Schwelle zu sensitiv gelegt wurde. Im schlimmsten Fall verliert der Mensch sogar das Vertrauen in die Anwendung. Es ist ein bisschen so, wie mit dem kleinen Hirtenjungen und dem Wolf. In der Forschung und in einigen Praxisanwendungen (zum Beispiel dem Wetterbericht) wird daher der Ansatz verfolgt, eine Eintrittswahrscheinlichkeit darzustellen - sogenannte „Likelihood Alarm Systems“ (LAS). Dieser Ansatz verspricht eine höhere Akzeptanz und ein verringertes Risiko an menschlichem Fehlverhalten mit KI. Was passiert nun, wenn der Mensch wirklich eingreifen muss? Nach einer längeren hochautomatisierten Phase denkbar schlecht. Ähnlich wie wenn man jahrelang kein Sport gemacht hatte und plötzlich der letzten Bahn im Niemandsland hinterhersprinten muss. Der wissenschaftliche Begriff hierzu ist „Human-out-of-the-loop“. Daher ist kontinuierliches Training der Nutzer notwendig, um einerseits übertriebenes Vertrauen entgegenzuwirken und selbst fit zu bleiben (indem zum Beispiel im Training verschiedene Arten von Ausfällen simuliert werden) oder auch um die eigene Leistung zusammen mit der KI zu sensibilisieren. Wir Menschen neigen bekanntlich auch dazu, uns selbst zu überschätzen.

Wie kann ich meine AI Trustworthiness „messen“?

Das war nun eine ganze Menge für einen ersten groben Überblick. Bei all den Aspekten, die es zu beachten gibt. Auf technischer wie auch organisatorischer Ebene stellt sich die Frage, ob das vergleichbar gemacht werden kann. Einen Ansatz zur quantifizierten Bewertung stellt das VDE SPEC 90012 V1.0 dar. Der VDE-Spec-Systematik liegt das VCIO-Modell zugrunde und steht für Value, Criteria, Indicator und Observables. Die Werte verdichten sich aus den Kriterien, die anhand der Indikatoren durch die Beobachtungen über eine Skala von A (höchste) bis G (niedrigste) bewertet werden können. Der Ansatz der Werte deckt sich ziemlich genau mit dem psychosomatischen Vertrauenskonstrukt. So ist es gar nicht verwunderlich, dass nahezu alle Aspekte im adesso Trustworthy AI Framework Prüfgegenstand wären. Die Mindestanforderungen je Value unterscheiden sich je nachdem an welcher Industriedomäne, vielleicht auch welchem konkreten Anwendungsfall die Systematik angewendet wird. Solche „Messlatten“ können aus Risikodomänen abgleitet werden wie die vier Beispiele unten dargestellt (Achtung Illustrativ!). Bei einer Anwendung, in der die ethischen Risiken relativ hoch sind, beispielsweise im medizinischen Bereich, wird es wahrscheinlich eine hohe Messlatte bei den Privacy- und Fairness-Werten geben. Bei einer Anwendung mit hohen Time-Loss-Risiken wird Privacy und Fairness eine eher untergeordnete Rolle spiele und die Reliability wird demgegenüber deutlich wichtiger. Die fünf Values aus dem VDE Spec sind in der Grafik unten auf das adesso Trustworthy AI Framework gemapped. Welche Aspekte prüft der VDE Spec nun nicht explizit? Alles, was nicht gegen Regeln verstoßen würde, wenn man es nicht tut. Dies wären sinnvolle Management-Strategien, Training der Mitarbeitenden und Anthropomorphismen. Wer keine sinnvollen Management-Strategien für die Mensch+KI-Kollaborationen etablieren würde, wird wahrscheinlich bald aus dem Markt aussteigen, daher ist es im eigenen Interesse dies zu tun. Wer keine guten Trainings für Mitarbeitende etabliert und anthropomorphe Eigenschaften in die KI-Systeme einbaut, hat ein ganz anderes Problem. Nehmen wir an, jedes Unternehmen schafft es, deren industriespezifischen Values auf einer Minimalausprägung zur Erfüllung. Dann bleibt nur noch der Differenzierungsfaktor über das Übertreffen der Minimalausprägungen. Dies ist der Weg zur Effektivitäts- und Effizienzsteigerung. Die Maximierung von Potenzialen ergibt sich über die Eigenschaften, die KI bisher nicht erfüllt. Dies sind die menschlichen Qualitäten wie Emotionalität und Kreativität. In der Wissenschaft spricht man auch schon von „Feeling Economy“. Die Bewegungen der Mass Customization haben gezeigt, dass Endkundinnen und -kunden mehr nach individuellen Services und Produkten nachfragen. Dies sind die Lösungsräume, die so verschieden sind, dass nur ein Mensch sich dieser annähern können würde.

Gegenüberstellung adesso TrAI Framework zu VDE SPEC 90012 V1.0 Values

Unser kurzer Ausflug zu den verschiedenen Risiken und deren Effekte auf die KI-Anforderungen lassen schon erahnen, wie es bald mit Risikomanagement Funktionen steht. Was könnt ihr nun für euch selbst mitnehmen? Das Thema erschlägt. Ein Nichtstun wird fatal ausfallen, denn die Baustellen sind groß und die Entscheidung liegt irgendwo zwischen den Anschluss an die KI -Transformation verlieren oder die KI-Transformation nicht beherrschen zu können.

Weitere spannende Themen aus der adesso-Welt findet ihr in unseren bisher erschienen Blog-Beiträgen.

Trustworthy AI - Das Dossier

Lassen Sie uns über Vertrauen reden

Wenn Trustworthy AI auch Ihre Aufgabenbereiche berührt, ist unser Dossier „Vertrauen lässt sich digitalisieren“ der kompakte Einstieg für Sie.