3. Dezember 2025 von Ellen Tötsch

Mehr als nur Chatbots- Dokumentenabgleich powered by Gemini

Welche Anwendungsfälle kommen euch als erstes in den Sinn, wenn es um große Sprachmodelle (LLMs) wie Gemini, GPT und Claude geht? Sicher hat das Ergebnis in den meisten Fällen mit Chat-Anwendungen zu tun. Kein Zufall, schließlich war es ChatGPT, das Ende 2022 wie ein Komet einschlug und die Arbeit für Machine Learning Engineers für immer verändert hat.

Wer bei Use Cases jedoch primär darüber nachdenkt, welche Rollen LLMs im Chat abdecken können, schränkt sich unnötig ein. LLMs können nämlich nicht nur ein Pläuschchen führen, sondern auch strukturierte Ergebnisse liefern. Dank des Output-Schemas muss man nicht mehr freundlich darum bitten, sondern kann das genaue Einhalten von Vorgaben zur Struktur auch erzwingen.

Der Dokumentenabgleich ist ein spannendes Anwendungsfeld von Sprachmodellen, das über Chats hinausgeht.

hagebau und die Herausforderung des Dokumentenabgleichs

Dieses Potenzial stand auch im Zentrum der Überlegungen des Einkaufsverbunds hagebau. Als große, international tätige Gruppe steht das Unternehmen täglich vor der Herausforderung, seine Prozesse zu optimieren, ohne die persönliche, kundenorientierte Beratung zu vernachlässigen. Eine der größten Herausforderungen war der zeitraubende und fehleranfällige manuelle Abgleich von Bestellungen und Auftragsbestätigungen – ein klassischer Fall für den Einsatz von LLMs, um die Effizienz zu steigern und die Mitarbeitenden zu entlasten.

Wenn Gesellschafter von hagebau, wie die innovationsoffene Bauwelt Delmes Heitmann, Bestellungen aufgeben, müssen die Daten aus ihrem Enterprise-Resource-Planning-System (ERP-System) mit der Auftragsbestätigung abgeglichen werden. Das ist eine mühselige Aufgabe, die viel Geduld und Aufmerksamkeit erfordert. Denn wie alle wissen, die schon einmal ein Haus gebaut haben, reichen bei Fenstern und Türen schon kleinste Abweichungen aus, um ein völlig unbrauchbares Produkt geliefert zu bekommen.

Der Abgleich von Bestellungen und Auftragsbestätigungen war für die operativ tätigen Kolleginnen und Kollegen bislang sehr zeitaufwendig. Trotz großer Sorgfalt ließen sich menschliche Fehler dabei nicht vollständig vermeiden. Das Ziel bestand darin, die Mitarbeitenden zu entlasten und ein intelligentes Werkzeug zu entwickeln, das diese aufwändige Tätigkeit deutlich effektiver gestaltet. So können sich die Teams stärker auf die Kundinnen und Kunden konzentrieren und wertvolle Zeit für persönliche Beratung und Betreuung nutzen.

Mit einer eigenen KI-Abteilung und einem GPT-Modell für interne Anwendungen etabliert die hagebau kontinuierlich neue Werkzeuge und zählt damit in der Branche zu den Vorreitern. Gerade diese Erfahrung hat jedoch gezeigt: Nicht jeder Anwendungsfall lässt sich mit Bordmitteln lösen. Beim automatisierten Abgleich von Dokumenten wurde schnell klar, dass dafür zusätzliche technologische Unterstützung benötigt wird. Deshalb entwickelte die hagebau gemeinsam mit der bauwelt Delmes Heitmann und adesso eine KI-gestützte Lösung, die den Prozess erheblich effizienter macht.

Ein Team aus GenAI- und UI-Engineers von adesso konzeptionierte im engen Austausch mit hagebau und der bauwelt darum einen teilautomatisierten Dokumentenabgleich, der nativ in der Google Cloud läuft. Der Star der Show: Gemini 2.5 Flash.

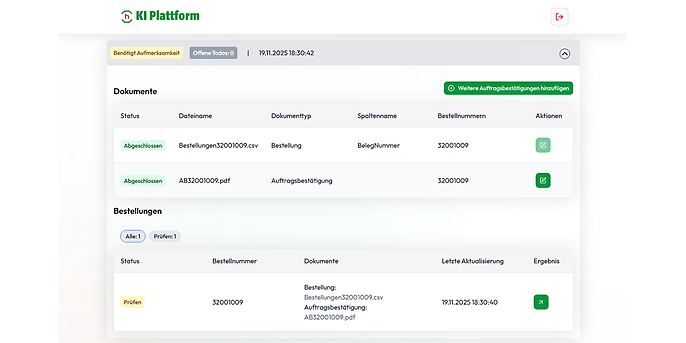

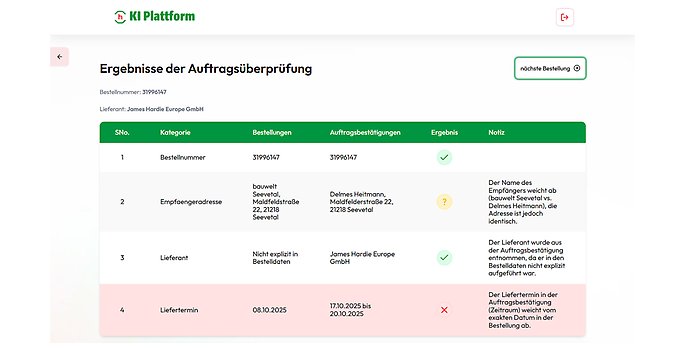

Um den Gesellschaftern einen schnellen Überblick über die relevanten Abweichungen zwischen den Dokumenten zu ermöglichen, werden die Ergebnisse des Vergleichs in einer Tabelle dargestellt. Diese ist nach Faktoren wie Lieferadresse, Artikelbeschreibung oder Einzelpreis aufgeschlüsselt. In der ersten Spalte stehen die Informationen aus der Bestellung, in der zweiten die aus der Auftragsbestätigung.

Ein Icon zeigt an, ob die Informationen übereinstimmen, abweichen oder der Fall nicht eindeutig ist. Wenn beispielsweise beide Dokumente die gleiche Lieferadresse enthalten, aber eines an den Eigennamen der Firma und das andere an den registrierten Handelsregisternamen adressiert ist, müssen die Nutzenden entscheiden, ob hier eine Diskrepanz vorliegt.

adesso & Google Cloud

Starke Partner für Ihre digitale Zukunft

Als zertifizierter Premier-Partner von Google Cloud verbinden wir mehr als 20 Jahre Erfahrung mit modernster Technik — von Cloud-Migration über Big Data und KI bis hin zu zukunftsweisenden Generative-AI-Lösungen. Mit über 1.100 umgesetzten Projekten und einem Team aus mehr als 100 Cloud-Fachleute gestalten wir eure Cloud-Journey maßgeschneidert, sicher und effizient.

Warum diese Aufgabe unbedingt ein LLM erforderte und nicht regelbasiert passieren konnte

Um die Gründe für die Entscheidung für eine LLM-basierte Lösung aufzuzeigen, ist es wichtig zu verstehen, wie Gemini genau eingesetzt wird. Der System-Prompt erklärt dem Sprachmodell haargenau, was die Aufgabe ist und wie es dabei vorzugehen hat. Das Output-Schema erzwingt eine Antwort im JSON-Format, das die Bedienoberfläche für die tabellarische Darstellung benötigt. Dabei wird kein Detail ausgelassen. Vor ihrer Einführung waren die Ergebnisse zwar auch schon recht gut, aber erst jetzt ist der Vergleich so einheitlich formatiert, dass sich Nutzende schnell an die Struktur gewöhnen können. Diese beiden „Baupläne“ führen Schritt für Schritt durch die zu vergleichenden Dokumente, die Arbeitsschritte des Vergleichs und das erwartete Ergebnis. Die Temperatur des Modells ist hier, wie für diese Art von Aufgabe üblich, bei 0, was ein Parameter bei LLMs ist und bestimmt, wie viel Kreativität und Willkür das Modell einbringen darf. Da hier besonders vergleichbare Ergebnisse ohne Fantasie gefragt sind, ist dieses Maß an Freiheit mit 0 minimiert.

Im Gegensatz zu anderen Lösungen erkennt das LLM bereits ab Werk viele Abweichungen als rein semantisch. Es erkennt nicht nur, dass Dinge unterschiedlich formuliert sein können und dennoch das Gleiche bedeuten, sondern meistert sogar Fälle, in denen der Artikel fehlt.

Die Benutzeroberfläche des KI-Dokumentenabgleichs: Gemini erkennt, dass mehrere Detailpositionen aus der CSV-Datei einer einzigen zusammengefassten Position im PDF entsprechen.

Das Dokument wurde auf mehrere Positionen in einem anderen Dokument aufgeteilt. Auch die kurze und bündige Erklärung, warum es sich (nicht) um eine Abweichung handelt, ist nur in dieser Form mit LLM möglich. Die Gesellschafter können zudem ihr eigenes Glossar für Abkürzungen und Synonyme pflegen. Dadurch versteht das LLM noch besser, wo die Unterschiede liegen. Dafür werden sie anhand ihrer Tenant-ID erkannt und zugeordnet.

Gemini 2.5 Flash: Eine strategische Entscheidung für Präzision und Effizienz

Dass die Wahl genau auf Gemini 2.5 Flash fiel, war kein Zufall. Gemini 2.5 Flash schneidet exzellent im Optical Character Recognition (OCR) ab und kann somit den Inhalt von Dokumenten gut lesen, selbst wenn diese nicht für die maschinelle Verarbeitung optimiert wurden oder handschriftlich sind. So müssen die Informationen aus dem PDF nicht erst von einem weiteren Modell extrahiert werden, wodurch womöglich Kontext verloren gehen würde. Weiterhin ist Gemini 2.5 Flash ein Thinking Model und kann somit in mehreren Stufen über ein Problem nachdenken, bevor es seine finale Antwort gibt. Das ist ein wichtiger Vorteil bei so komplexen Vergleichen, da nicht nur Muster erkannt, sondern die Dokumente „verstanden“ werden.

Außerdem ist Gemini 2.5 Flash marktführend unter den LLMs im Rechnen. Während andere Modelle noch daran scheitern, simple Zahlen zu addieren, kann Gemini eigenständig Gesamtpreise aus Stückpreisen, Mengen und Rabatten berechnen und vergleichen. Das ist äußerst hilfreich, da in manchen Dokumenten die Anzahl der Fenster und der Preis pro Fenster angegeben sind, während in anderen Dokumenten dieser Wert in der Gesamtfläche dieser Fenster und dem Preis pro Quadratmeter bemessen ist.

Technische Umsetzung im POC

Die Bedienoberfläche ist in eine bestehende hagebau-Plattform integriert, die on-prem läuft. Damit ist sie der einzige Teil des Dokumentenabgleichs, der nicht cloudnativ umgesetzt wird. Ein Service-Account berechtigt das Frontend, das Backend anzusprechen. Dieses Backend wird als Container im vollständig gemanagten Container-Service Google Cloud Run von Google Cloud gehostet.

In unserem POC nimmt ein Endpunkt die zwei zu vergleichenden Dokumente, den Namen des Gesellschafters und die Bestellnummer entgegen. Darauf basierend werden alle nötigen Informationen aus den Dokumenten extrahiert und das Glossar des Gesellschafters geladen. Anschließend werden die Dokumente, der Systemprompt und das Output-Schema zusammen mit dem Glossar an den Gemini-Endpunkt übergeben. Zurück kommt der Inhalt, mit dem die Tabelle befüllt wird, die anschließend in der Bedienoberfläche angezeigt wird.

Roadmap: Neuerungen im MVP und denkbare zukünftige Erweiterungen

Das erste Feedback der Testenden von Bauwelt Delmes Heitmann ist durchweg positiv – die Begeisterung über die neue Lösung ist deutlich spürbar. Der Dokumentenabgleich befindet sich derzeit in der finalen Optimierungsphase, in der die letzten Details abgestimmt werden. Anschließend soll das MVP (Minimum Viable Product) in größerem Maßstab ausgerollt werden, um die Vorteile der teilautomatisierten Lösung flächendeckend nutzbar zu machen. Dabei steht die adesso im steten Dialog mit den Kundinnen und Kunden. Neben der technischen Härtung, um den Dokumentenabgleich für einen produktiven Einsatz vorzubereiten, stehen auf der Roadmap vor allem Features, die die Nutzung weiter vereinfachen sollen:

- Erkennung der Belegnummern: Im POC mussten die Bestellnummern immer händisch eingetragen werden. Um die Nutzung zu beschleunigen und zu vereinfachen, werden Bestellnummern zukünftig mit Gemini aus den Dokumenten ausgelesen. Nur wenn keine Nummer gefunden werden kann, werden die Nutzenden aufgefordert, sie manuell zu ergänzen. Da die Extraktion der Bestellnummern im MVP weniger komplex ist und besonders schnell erfolgen soll, kommt hier das noch flinkere und günstigere Gemini 2.5 Flash-Lite zum Einsatz.

- Multiupload: Bisher konnten immer nur die Dokumente einer einzigen Bestellung hochgeladen werden. Im MVP ist es möglich, mehrere Bestellungen gleichzeitig zu verarbeiten. Dazu werden die Dokumente zunächst in den Cloud Storage hochgeladen. Im Firestore wird anschließend erfasst, zu welchen Bestellungen bereits Daten vorliegen, was fehlt und wie der Status des Vergleichs ist.

- Weitere Dateiformate: Ursprünglich konnte der Dokumentenvergleich nur ERP-Exporte in CSV-Form und Auftragsbestätigungen in PDF-Form verarbeiten. Nach Rücksprache mit den Testenden wurde klar, dass dies nicht ausreicht. Deshalb werden im MVP weitere Dateiformate verarbeitbar sein.

- Verbesserung der Bedienoberfläche: Dank des ausführlichen Feedbacks aus der Testphase konnten einige Stellen ermittelt werden, die eine intuitivere und benutzerfreundlichere Gestaltung der Bedienoberfläche ermöglichen.

Auch nach der Umsetzung der aktuell vereinbarten MVP-Features gibt es bereits Pläne für mögliche zukünftige Features:

- Automatisierter Datenimport über Nacht: Eine vollständige Automatisierung des Datenimports durch nächtliche Exporte der Bestelldaten in die Google Cloud würde den Aufwand für die Nutzenden deutlich verringern und die Effizienz des Dokumentenvergleichs steigern.

- Individuelle Schwellenwerte: Im Proof of Concept können Nutzerinnen und Nutzer bereits ihren Glossar pflegen. In Zukunft sollen sie auch individuelle Grenzen wählen können, ab wann beispielsweise eine Preisabweichung als Diskrepanz zu werten ist. Dadurch wird die Trefferquote erhöht und der Zeitaufwand der Nutzenden reduziert.

- Zugriff auf vergangene Vergleiche und Dokumente: Eine weitere denkbare zukünftige Erweiterung ist die Möglichkeit, auf eine Historie von Vergleichen und die ursprünglichen Dokumente zuzugreifen.

Diese teilautomatisierte Dokumentenabgleichs-Lösung zeigt, dass LLMs wie Gemini zu mehr fähig sind als nur Chatbots und RAGs (Retrieval Augmented Generation). Dank Geminis Präzision in den Bereichen OCR, analytisches Denken und Rechnen konnte adesso hier eine cloudnative Lösung entwickeln, die dem Kunden enorm viel Arbeit abnimmt und den Wissenstransfer vereinfacht.

Wir unterstützen euch!

Möchten auch ihr eure Geschäftsprozesse mit KI automatisieren oder LLMs wie Gemini effizient in eurem Unternehmen einsetzen? Dann sprecht mit unseren Expertinnen und Experten – adesso begleitet euch von der ersten Idee bis zum produktiven Einsatz.