7. Juli 2025 von Kaan Güllü

Zwischen Innovation und Verantwortung – Warum die AI-Folgenabschätzung jetzt entscheidend ist

Der Aufstieg der KI – aber zu welchem Preis?

„Künstliche Intelligenz (KI) wirkt sich zunehmend auf unser Leben aus. Sie bietet Chancen, birgt aber auch Risiken – insbesondere für Sicherheit, Demokratie, Unternehmen und Arbeitsplätze.“

Mit diesen Worten leitet das Europäische Parlament (EuroParl) ihren Artikel zum AI-Act ein.

Sei es im privaten oder beruflichen Umfeld, KI ist nicht mehr wegzudenken. Die Anwendungsfälle reichen von GPTs, die unkompliziert viel Wissen bereitstellen, verändern oder generieren können, bis hin zu KI-Agenten, die spezifische Aufgaben automatisiert durchführen. Sowohl für Unternehmen als auch für unsere Gesellschaft gibt es verschiedenste Anwendungsfälle von KI, die uns schützen und helfen können.

Das Europarlament führt über die Chancen hinaus auch explizite Risiken auf, die als Beweggründe für die Verabschiedung der europäischen KI-Verordnung (AI-Act) gesehen werden können: Einerseits, wenn wir uns als Gesellschaft nicht intensiv genug mit dem Thema KI auseinandersetzen, die uns sicherer oder effizienter hätten machen können, entfallen uns Chancen. Andererseits kann eine übermäßige Nutzung von KI dazu führen, dass Ressourcen verschwendet werden oder KI für ungeeignete Aufgaben eingesetzt wird. Hier die Balance zu halten, ist unsere gemeinschaftliche Verantwortung. Dies gilt für uns als Bürgerinnen und Bürger ebenso wie für Organisationen.

Das EuroParl legt aber darüber hinaus noch einen besonderen Wert auf die Gefahren für Grundrechte und Demokratie. Auswirkungen von KI auf unsere Gesellschaft können tiefgreifend sein – sowohl im positiven als auch im negativen Sinne. Entscheidungen, die durch KI-Systeme getroffen werden, basieren stets auf Designentscheidungen und Datengrundlagen. Werden dabei strukturelle Verzerrungen oder blinde Flecken nicht erkannt, können KI-Systeme Diskriminierung reproduzieren oder sogar verstärken – etwa bei Jobeinstellungen, Kreditvergaben oder Strafverfolgung.

Ein Fall, der vor allem in den US-amerikanischen Medien intensiv behandelt worden ist, hängt mit der Veröffentlichung der Apple-eigenen Kreditkarte (Apple Card) in Kooperation mit der US-amerikanischen Bank Goldman Sachs zusammen. Verschiedene öffentliche Personen erhielten unterschiedliche Kreditrahmen. Steve Wozniak, Mitbegründer von Apple Inc., erhielt beispielsweise einen anderen Kreditrahmen als seine Frau. In ihrer Untersuchung stellte die zuständige Regulierungsbehörde, das New York State Department of Financial Services (NYSDFS), fest, dass das zugrundeliegende KI-System nicht ausreichend nachvollziehbar war. Dadurch kam es bei der Kreditvergabe zu unbeabsichtigten Benachteiligungen.

In diesem Zusammenhang ist auch der Schutz der Privatsphäre ein relevantes Thema, da KI zunehmend für Gesichtserkennung, Tracking und Profiling eingesetzt wird. Gleichzeitig gefährden jedoch personalisierte Fehlinformationen und realistisch wirkende Deepfakes den öffentlichen Diskurs und die demokratische Meinungsbildung. In autoritären Kontexten können solche Technologien die Versammlungsfreiheit untergraben und zivilgesellschaftliches Engagement erschweren.

An dieser Stelle setzt die KI-Folgenabschätzung an. Als zentrales Instrument des AI-Acts und der Norm ISO/IEC 42001:2023 dient sie dazu, Risiken frühzeitig zu erkennen, systematisch zu bewerten und gezielt zu begrenzen. Neben technischer Robustheit sind hierbei insbesondere Verantwortung, Transparenz und menschenzentriertes Design von entscheidender Bedeutung. Was der EU AI Act für Sie konkret bedeutet, könnt ihr auf unsere Website nachlesen.

Was ist eine AI-Folgenabschätzung überhaupt?

Wie bereits erwähnt handelt es sich bei der KI-Folgenabschätzung um eine spezifische Anforderung aus dem AI-Act und auch der Norm ISO/IEC 42001:2023. Mithilfe der KI-Folgenabschätzung, die auch als Grundrechte-Folgenabschätzung bezeichnet wird, sollen die Auswirkungen eines KI-Systems auf die Grundrechte, die Gesundheit und die Sicherheit von Personen oder der Gesellschaft bewertet werden. Sie gilt insbesondere für bestimmte Hochrisiko-KI-Systeme.

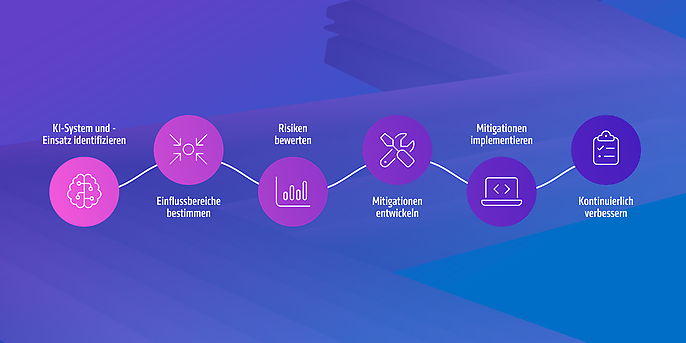

Das genaue Vorgehen wird noch durch das AI-Office der Europäischen Kommission ausgearbeitet, sollte sich in der Umsetzung aber in folgende Schritte gliedern:

Bei näherer Betrachtung fällt auf, dass die Elemente einer KI-Folgenabschätzung dem Aufbau und Zweck einer Datenschutzfolgenabschätzung gemäß DSGVO ähneln.

Wie in anderen Bereichen auch bietet es sich in der praktischen Umsetzung an, auf bestehenden Prozessen aufzubauen.

Warum sollte man jetzt die KI-Folgenabschätzung durchführen?

Den Expertinnen und Experten für Datenschutz unter uns ist bekannt, dass gemäß Art. 35 Abs. 1 DSGVO eine Datenschutzfolgeabschätzung durchgeführt werden muss, bevor personenbezogene Daten (PBDS) verarbeitet werden dürfen. Diese Vorgabe gibt es auch im AI-Act. Gemäß Art. 27 AI-Act muss vor Inbetriebnahme eines KI-Systems eine sogenannte „Grundrechte-Folgenabschätzung“ durchgeführt werden. Dies gilt insbesondere für KI-Systeme mit hohem Risiko.

GenAI Impact Report 2025

50 % der Unternehmen sind bereit – Und der Rest?

Wie gut ist die deutsche Wirtschaft auf den Wandel durch GenAI vorbereitet? Wie sehen die Verantwortlichen ihre Branche und unser Land aufgestellt? Wo bringt die Technologie schon heute echte Effizienzgewinne? Und wo gibt es noch Hürden?

Findet es heraus, in unserem neuen GenAI Imact Report 2025.

In welchen Bereichen muss die KI-Folgenabschätzung vor allem durchgeführt werden?

Aus Anhang III des AI-Acts ergeben sich die Anwendungsfälle von KI-Systemen, die unter den Begriff "hohes Risiko" fallen. Dies betrifft insbesondere Bereiche, in denen Entscheidungen durch KI direkte Auswirkungen auf das Leben, die Sicherheit oder die Rechte von Menschen haben.

- Bei Systeme zur biometrischen Identifikation, etwa zur Fernidentifikation von Personen oder zur Erkennung sensibler Merkmale und Emotionen.

- In der kritischen Infrastruktur, etwa bei der Steuerung der Energieversorgung, digitalen Netzen oder im Straßenverkehr, wird der Einsatz von KI mit hohen Risiken assoziiert.

- Im Bildungssektor fallen KI-Systeme unter diese Kategorie, wenn diese über Zugang, Leistungsbewertung oder Prüfungsverhalten entscheiden.

- Im Beschäftigungskontext betrifft das unter anderem KI-Systeme zur Bewerberauswahl, zur Bewertung von Mitarbeitenden oder zur automatisierten Aufgabenverteilung. Das betrifft ebenfalls den Zugang zu wesentlichen Dienstleistungen - unter anderem Sozialleistungen, Krediten, Versicherungen oder Notrufsystemen.

- Bei der Strafverfolgung erfordert der Einsatz von KI besondere Sensibilität. Dies betrifft den Einsatz von KI zur Einschätzung von Rückfallrisiken, zur Beweismittelbewertung oder als Lügendetektor.

- Im Migrations- und Grenzmanagement ist ebenfalls Vorsicht geboten, beispielsweise bei der Risikobewertung oder der Unterstützung bei Asylentscheidungen.

- Die Justiz und demokratische Prozesse können auch betroffen sein . KI-Systeme, die bei gerichtlichen Entscheidungen unterstützen oder gezielt das Wahlverhalten beeinflussen, unterliegen ebenfalls den strengen Anforderungen des AI-Acts.

Bei Betrachtung dieser Anwendungsfälle bzw. -bereiche fällt auf, dass in dem einen oder anderen Bereich sicher schon KI-Systeme eingesetzt werden. Das bedeutet, dass gemäß dem AI-Act in diesen Bereichen mindestens nachträgliche KI-Folgenabschätzungen durchgeführt werden müssen und die Verwendung des KI-Systems in bestimmten Fällen bis zur Durchführung der KI-Folgenabschätzung eingestellt werden muss.

Exkurs:

Im Juni 2025 verhängte die Bundesnetzagentur gegen einen Anbieter einer Medizin-KI ein Bußgeld in Höhe von rund zwei Millionen Euro wegen fehlender Risikobewertung. Obwohl die Sanktionen des AI-Act offiziell erst ab August 2025 gelten, ermöglicht das in Deutschland bereits geltende Marktüberwachungsgesetz der Bundesnetzagentur, frühzeitig Maßnahmen zu ergreifen. Dieses nationale Gesetz ergänzt den AI-Act und schafft eine rechtliche Grundlage, um bereits vor Inkrafttreten des europäischen Strafrahmens Verstöße effektiv zu ahnden.

Fazit: AI-Folgenabschätzung als strategisches Werkzeug

Die KI-Folgenabschätzung ist aber mehr als nur eine regulatorische Pflicht. Sie ist ein strategisches Werkzeug, um Vertrauen in den Einsatz von KI zu schaffen, Risiken systematisch zu beherrschen und gesellschaftliche sowie unternehmerische Verantwortung wahrzunehmen. Ihr Mehrwert zeigt sich nicht nur in der rechtlichen Absicherung, sondern auch im gezielten Aufbau robuster, fairer und transparenter KI-Systeme, die sowohl den Unternehmenserfolg als auch das Gemeinwohl fördern.

Um diesem Anspruch gerecht zu werden, ist eine proaktive und interdisziplinäre Haltung erforderlich. Die Fachbereiche, die IT, die Rechtsabteilung, der Datenschutz, die Ethik und die Informationssicherheit müssen gemeinsam wirksame Bewertungsverfahren etablieren. Die frühzeitige Identifizierung kritischer Einsatzbereiche, die Vermeidung von Fehlentwicklungen und die sichere Ausschöpfung von Potenzialen sind auf diese Weise möglich.

Die Implementierung der KI-Folgenabschätzung als gelebte Standardpraxis sollte daher das Ziel jeder Organisation sein, die KI verantwortungsvoll nutzen möchte.

Wir unterstützen euch!

adesso unterstützt Organisationen ganzheitlich beim Aufbau eines nachhaltigen KI-Governance-Rahmens. Wir begleiten euch:

- bei der Identifikation relevanter KI-Anwendungsfälle,

- bei der Durchführung und Dokumentation der KI-Folgenabschätzung (an ISO/IEC 42001 und AI-Act orientiert),

- beim Aufbau integrierter AI-Managementsystem-Prozesse entlang bestehender Datenschutz-, IT-Risiko- und IT-Compliance-Strukturen,

- beim Aufbau eines AI-Managementsystems nach ISO/IEC 4200:2023 sowie

- bei der Schulung interner Stakeholder zur Sicherstellung einer organisationseinheitlichen Umsetzung. (Hier findet ihr Schulungen in Kooperation mit unserem Partner qSkills zum Thema AIMS-Implementer.)

So wird die KI-Folgenabschätzung nicht zum Bremsklotz – sondern zum Enabler für vertrauenswürdige Innovation.

Und nun?

Wir unterstützen Unternehmen dabei, ein AIMS gezielt und praxisnah aufzubauen – von der ersten Reifegradanalyse bis hin zur vollständigen Integration in bestehende Managementsysteme. Unser interdisziplinäres Team aus Fachleuten für IT-Governance, IT-Risiko- und IT-Compliance-Management sowie KI-Technologie begleiten euch ganzheitlich auf dem Weg zu einer sicheren, regelkonformen und vertrauenswürdigen KI-Nutzung.