17. September 2021 von Ann-Kathrin Bendig und Jan Jungnitsch

Von der Blackbox zur Whitebox

Explainable AI ebnet den Weg für den Einsatz von Künstlicher Intelligenz in der Versicherungsbranche

Vertrauen, Schutz, Sicherheit

Das kundenseitige Bedürfnis nach Schutz, Vertrauen und Sicherheit ist in keiner anderen Dienstleistungsbranche so ausgeprägt wie bei Versicherern. Durch den Risikotransfer ist der Versicherungsnehmer im Schadenfall von dem Schutzversprechen seines Versicherers und damit von dessen Leistung abhängig, um nicht in eine wirtschaftliche Notlage zu geraten. Die Ablehnung einer Schadenzahlung kann für viele Versicherte schon den wirtschaftlichen Ruin bedeuten. Transparenz darüber, wieso, weshalb und warum bestimmte Entscheidungen getroffen werden – egal ob durch den Menschen oder eine KI –, hat in der Versicherungsbranche also oberste Priorität.

Die Versicherer zählen mit acht regulatorischen Behörden auf nationaler und EU-Ebene mit zu den am stärksten regulierten Unternehmungen in Deutschland. Es ist klar, dass genau diese Aufsichten auch Einfluss auf Fortschritt und neue Geschäftsmodelle nehmen. Im Zusammenhang mit dem Einsatz von Künstlicher Intelligenz macht die BaFin deutlich: Blackbox-Anwendungen werden in aufsichtspflichtigen Modellen nicht akzeptiert. Der Entscheidungsweg, das heißt, wie die KI auf ihr Ergebnis kommt, muss nachvollziehbar und für alle Akteure transparent kommunizierbar sein. Wir benötigen eine Umwandlung der Blackbox in eine Whitebox. Genau an dieser Stelle kommt Explainable AI (XAI) ins Spiel.

Was ist Explainable AI?

Explainable AI (XAI) ist ein methodischer Ansatz, der die kunden- und aufsichtsrechtlich geforderte Nachvollziehbarkeit von Entscheidungen ermöglicht. XAI erklärt die vergangenen, gegenwärtigen und zukünftigen Aktionen der Künstlichen Intelligenz. Kurz gesagt geht es bei XAI um ein Maximum an Transparenz beim Einsatz von KI. Die damit gewonnene Traceability von Entscheidungen könnte die Nutzbarkeit in der Versicherungsbranche deutlich erhöhen und durch die Erfüllung der rechtlichen Vorgaben einen Meilenstein beim Einsatz von KI in der Versicherungsbranche darstellen.

Von der Blackbox zur Whitebox?

Im Bereich der Künstlichen Intelligenz gibt es zwei methodische Ansätze. Der klassische Ansatz ist die Blackbox, bei der Trainingsdaten in einen Lernprozess geschickt werden. Als Anwenderin oder Anwender bekomme ich zwar ein Ergebnis von der KI, aber in der Regel keine Antwort auf die Frage, warum etwas so gelöst wurde. Beim erklärbaren Ansatz gibt es darüber hinaus eine sog. Abstraktionsschicht. Es existiert also ein Modell, das losgelöst arbeitet und auf einer anderen Ebene die Ergebnisse des tatsächlichen Modells extrahiert. Mit Hilfe eines Erläuterungsinterface bekommt der Anwendende also Antworten auf die Fragen, warum und mit welcher Wahrscheinlichkeit eine Entscheidung getroffen wurde. Man kann also verstehen und nachvollziehen, wieso die KI etwas auf eine bestimmte Art und Weise entscheidet.

Nutzergruppen als neue Herausforderung

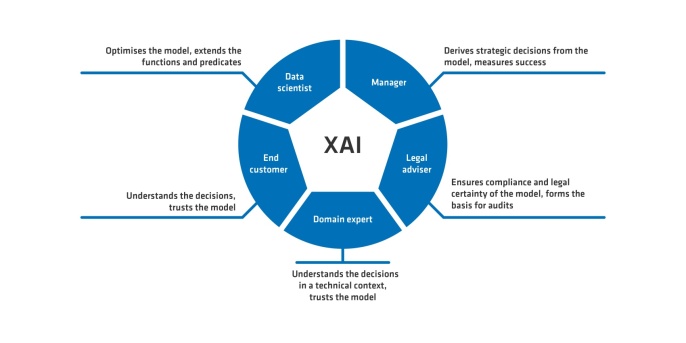

Eine neue Herausforderung bei XAI stellen die Nutzergruppen dar, die aus ihrer Rolle heraus unterschiedliche Anforderungen an die Erklärungen über das gleiche Modell haben. Manager und Executives erwarten Antworten auf einer strategischen Abstraktionsebene und messen zudem die Erfolgsquote (KPI) des Modells. Die regulatorische Entität hat einen Anspruch an die Compliance des Modells sowie dessen Rechtssicherheit. Der Domänenexperte als operative Entität benötigt für sein Tagesgeschäft Vertrauen in das Modell und leitet die eigenen Handlungen daraus ab. Zudem gibt es Nutzerinnen und Nutzer, im engen Sinne in der Rolle des Versicherungsnehmers, die die Entscheidung der KI auf einer ganz anderen Abstraktionsebene verstehen müssen. Schließlich haben sie als Laien keine Kenntnisse über Lernverfahren und das Modell, das heißt, die Grundlage der Entscheidung muss hier anders erläutert werden. An dieser Stelle kommen Eigenschaften ins Spiel die voraussetzen, dass eine Entscheidung fair und vertrauensvoll sein soll und zudem die Privatsphäre des Users berücksichtigen muss. Schließlich gibt es die eigentlichen Technikerinnen und Techniker – etwa Data Scientists, Product Owner und Software Engineers –, die tiefe technische Expertise besitzen und den Transformationsprozess steuern.

Bei XAI wird letztendlich eine andere, neue Herangehensweise gefordert, da tiefgreifend und umfangreicher an die Ebene der Abstraktion und Erläuterung herangegangen werden muss. So steigen auch die Qualifikationen der Data Scientists bezüglich ihrer Fachlichkeit, da die Aufmerksamkeit auf die Abstraktionsebene (GUI) zum Nutzer an Bedeutung gewinnt.

Die Methoden einer XAI sind zweifelsohne die Voraussetzung, dass Künstliche Intelligenz bei Versicherern eingesetzt wird, da nur durch die Erklärbarkeit der geforderte Anspruch an Transparenz und der versicherungsspezifische Grundgedanke von Vertrauen, Schutz und Sicherheit erfüllt werden können.

Ihr möchtet gern mehr über spannende Themen aus der adesso-Welt erfahren? Dann werft doch auch einen Blick in unsere bisher erschienenen Blog-Beiträge.