15. Dezember 2023 von Marc Mezger

Mistral und Phi – Die Revolution mit kleinen (finegetunten) Sprachmodellen?

In der Welt der Künstlichen Intelligenz (KI) wurde bisher oft angenommen, dass größere Modelle besser sind. Neuere Forschungen zeigen jedoch, dass kleinere Sprachmodelle, die bisher nur als Zwischenschritte zu ihren größeren Pendants betrachtet wurden, in verschiedenen Anwendungen die Leistung großer Sprachmodelle (LLMs) übertreffen oder zumindest erreichen.

Die Entwicklung von LLMs wie GPT-4 hat bemerkenswerte Fähigkeiten beim Verstehen und Erzeugen natürlicher Sprache gezeigt, aber auch erhebliche Nachteile wie hohen Energieverbrauch, großen Speicherbedarf und hohe Rechenkosten. Daher untersuchen Forscherinnen und Forscher das Potenzial kleinerer Sprachmodelle, die in bestimmten Anwendungen effizienter und vielseitiger sein könnten.

Neue Techniken und Forschungsergebnisse zeigen, dass kleinere Sprachmodelle, wenn sie verfeinert werden, bei bestimmten Aufgaben eine ähnliche oder sogar bessere Leistung erzielen können als ihre größeren Pendants. Außerdem können sie durch Techniken wie Transferlernen vorhandenes Wissen nutzen und sich effizienter an spezifische Aufgaben anpassen.

Die Entwicklung

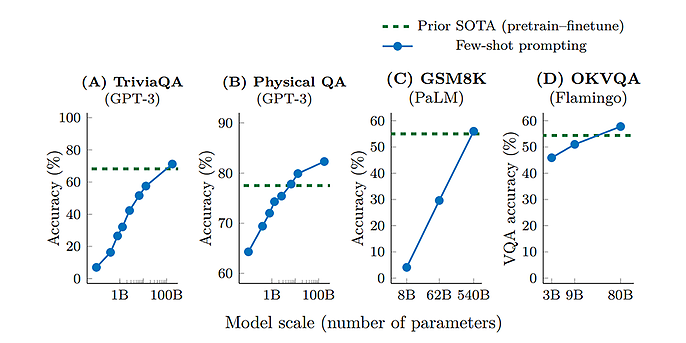

Große Sprachmodelle wie GPT-3 und GPT-4 von OpenAI oder Luminous von Aleph Alpha haben in den letzten Jahren erhebliche Fortschritte gemacht, vor allem aufgrund der ständig wachsenden Größe dieser Modelle. Der Grund für diese Entwicklung liegt in der "Scale-up"-Hypothese, die besagt, dass größere Modelle in der Lage sind, komplexere und subtilere Muster in den Daten, die sie trainieren, zu erkennen. Größere Modelle sind besser in der Lage, die Vielfalt und Komplexität der menschlichen Sprache zu erfassen. Dies führt im Allgemeinen zu besseren Vorhersagen und relevanteren Antworten. Dies wurde in einer Reihe von Benchmarks und Tests nachgewiesen, in denen größere Modelle besser abschnitten als ihre kleineren Pendants. Allerdings haben diese größeren Modelle auch Nachteile: Sie benötigen erheblich mehr Ressourcen für das Training und den Betrieb, sowohl in Bezug auf die Rechenleistung als auch auf die Daten. Außerdem können sie schwieriger zu steuern sein und unerwartete oder ungeeignete Antworten liefern. Trotz dieser Herausforderungen hat die kontinuierliche Skalierung der Modellgröße dazu beigetragen, die Leistung von Sprachmodellen zu verbessern und neue Anwendungsfälle zu ermöglichen.

Diese Diagramme zeigen, dass die Genauigkeit mit der Größe zunimmt. Dies entspricht der Hypothese, dass mehr Parameter zu besseren Ergebnissen führen, Quelle: Emergent Abilities of Large Language Models

Datenqualität schlägt Größe

Statt immer mehr Parameter hinzuzufügen, konzentrieren sich die Forscherinnen und Forscher nun auf eine bessere Datennutzung und effizientere Trainingsstrategien. Die Hypothese: Ein gut trainiertes kleineres Modell könnte ein schlecht trainiertes größeres Modell übertreffen.

Chinchilla

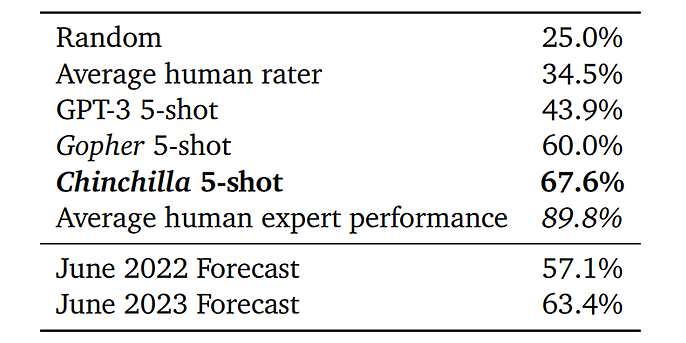

"Chinchilla" von Google Deep Mind (https://arxiv.org/pdf/2203.15556.pdf) bietet fundierte Untersuchungen zum Training von Large Language Models (LLMs). Die Autoren weisen auf einen "optimalen Punkt" im LLM-Trainingsprozess hin, jenseits dessen eine Erhöhung der Parameterzahl nicht notwendigerweise zu einer verbesserten Leistung führt.

Sie betonen auch die entscheidende Rolle der Qualität und des Umfangs der Trainingsdaten, anstatt sich nur auf die Größe des Modells zu konzentrieren. Diese These wurde empirisch anhand von "Chinchilla" getestet, einem Modell mit 70 Milliarden Parametern, das auf einer Datenmenge von 1,4 Milliarden Tokens trainiert wurde. Trotz seiner relativ geringen Größe zeigt Chinchilla eine überlegene Leistung gegenüber dem Modell "Gopher" mit 280 Milliarden Parametern in fast allen Evaluierungsmetriken. Diese Ergebnisse könnten bedeutende Auswirkungen auf die zukünftige Entwicklung und das Training von LLMs haben.

Die Autorinnen und Autoren haben nicht nur die Leistung ihrer Modelle verglichen, sondern auch die Effizienz der Modelle in Bezug auf die verwendete Rechenleistung. Dieser Aspekt ist besonders wichtig, da das Training von Large Language Models (LLMs) erhebliche Rechenressourcen benötigt, was sowohl finanzielle als auch ökologische Auswirkungen hat.

Die Studie zeigt, dass Chinchilla trotz der kleineren Modellgröße eine bessere Leistung als Gopher erbringt und dabei weniger Rechenleistung für Training und Inferenz benötigt. Das bedeutet, dass Chinchilla nicht nur einen Vorteil in der Leistung, sondern auch in der Effizienz hat.

Schließlich liefert die Studie wichtige Erkenntnisse für die Optimierung des Trainings von LLMs. Die Autoren weisen darauf hin, dass eine Erhöhung der Modellgröße allein nicht ausreicht, um die Leistung zu verbessern. Vielmehr sollte ein Gleichgewicht zwischen der Modellgröße und der Menge und Qualität der Trainingsdaten angestrebt werden.

Die Ergebnisse für den MMLU-Task, Quelle: Training Compute-Optimal Large Language Models

Llama 1 & 2

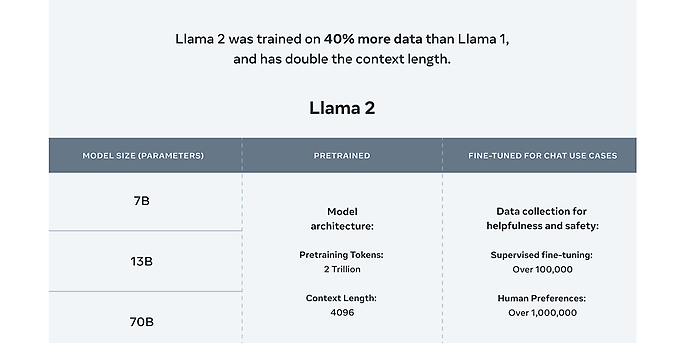

LLaMA und LLaMA 2 repräsentieren eine neue Generation von LLMs, die von Facebook/Meta AI entwickelt wurden. Diese Modelle wurden mit Billionen von Token aus einer Vielzahl von Quellen trainiert, darunter CommonCrawl, C4, Github, Wikipedia, Books, ArXiv und Stack Exchange. Die Größe der LLaMA-Modelle variiert zwischen sieben Milliarden und 65 Milliarden Parametern und kann mit bereits existierenden LLMs wie GPT-3, Gopher, Chinchilla und PaLM konkurrieren und diese in einigen Fällen sogar übertreffen. LLaMA 2, die neueste Entwicklung in Meta's Open Source Sprachmodellreihe, ist im Gegensatz zu Llama1 für Forschungszwecke und kommerzielle Anwendungen frei verfügbar. Zusätzlich gibt es fein abgestimmte Modelle für Coding und Chatting. Die finegetunten Modelle basieren auf über eine Million menschlichen Annotationen. Sowohl Llama 1 als auch Llama 2 waren zum Zeitpunkt ihrer Veröffentlichung jeweils der neueste Stand der Technik.

Das feingetunte Modell LlaMA 2 Chat verwendet öffentlich zugängliche Datensätze und über 1 Million menschliche Annotationen. Code LLaMA, ein auf LLaMA 2 basierendes Codegenerierungsmodell, wurde mit 500 Milliarden Code-Token trainiert. Es unterstützt gängige Programmiersprachen wie Python, C++, Java, PHP, Typescript (Javascript), C# und Bash.

Quelle: ai.meta.com/llama

Mistral -7B

Mistral 7B ist ein LLM mit sieben Milliarden Parametern, das speziell zur Optimierung von Leistung und Effizienz entwickelt wurde. In einer Vielzahl von Benchmark-Tests, die Bereiche wie Logik, Mathematik und Codegenerierung abdecken, hat Mistral 7B bestehende Modelle übertroffen. Zusätzlich wurde eine spezielle Version, Mistral 7B - Instruct, entwickelt, die speziell auf das Befolgen von Anweisungen ausgerichtet ist.

Veröffentlicht unter Apache 2.0, einer echten Open-Source-Lizenz, ermöglicht sie die kommerzielle und private Nutzung durch jedermann und jede Organisation. Mit den leistungsstarken Finetuning-Chat-Modellen Zephyr und Notus stehen bereits hervorragende Chat-Modelle zur Verfügung. Hinter Mistral steht das französische Start-up Mistral AI, ein Unternehmen, das sich auf die Entwicklung von generativen KI-Modellen spezialisiert hat. Mistral AI wurde von ehemaligen Mitarbeitern von Googles DeepMind und Meta gegründet und hat seinen Sitz in Paris. Obwohl das Unternehmen erst 2023 gegründet wurde, hat es bereits bemerkenswerte Erfolge erzielt, indem es in kürzester Zeit mehr als 113 Millionen Euro an Seed-Finanzierung generiert und nur drei Monate später ein neues, hochmodernes Modell mit sieben Milliarden Parametern auf den Markt gebracht hat.

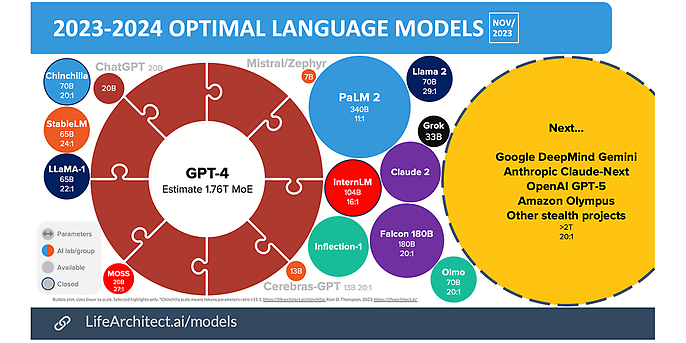

In diesem Bild ist zu sehen, welche Größen die neuen Modelle besitzen, Quelle: Life Architect

Phi

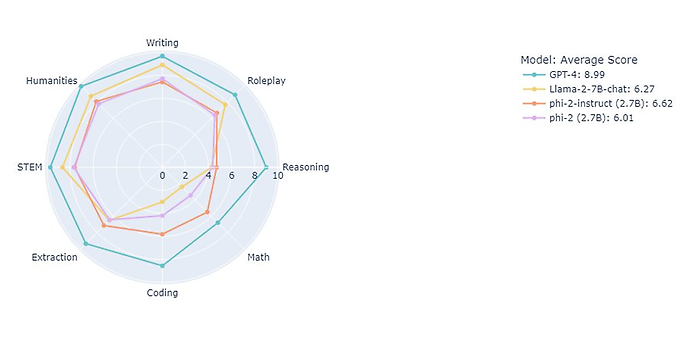

Microsoft hat im Laufe des Jahres eine Reihe von Sprachmodellen veröffentlicht: Phi-1 im Juni, Phi 1.5 einige Monate später und nun zuletzt im November Phi-2. Interessanterweise waren diese Modelle trotz ihrer relativ geringen Größe von 1,3 Milliarden bis 2,7 Milliarden Parametern in ihrer Leistungsfähigkeit fast gleichwertig mit Modellen, die fast doppelt so groß waren. Die Fähigkeiten dieser Modelle reichen vom Schreiben von Code bis zur Analyse von Bildern.

In ihrem Paper "Textbooks are all you need" (https://arxiv.org/abs/2306.11644) erklärt das Microsoft-Forschungsteam, wie es möglich ist, ein so kleines Modell zu einer hohen Leistungsqualität zu führen. Ein wesentlicher Aspekt des Trainingsprozesses ist die Verwendung von qualitativ hochwertigen Daten, die eher einem Lehrbuch ähneln als den üblichen unstrukturierten Daten aus dem Internet. Die Autorinnen und Autoren argumentieren, dass dieser Ansatz die Leistungsfähigkeit des Modells erhöht und gleichzeitig die Kosten und die Umweltauswirkungen des Trainings minimiert. Ein Teil der verwendeten Daten wird von einem anderen Sprachmodell, GPT-3.5, synthetisch erzeugt, während ein anderer Teil aus bereits existierenden Code-Datensätzen gefiltert wird. Um die Fähigkeiten des Modells weiter zu verfeinern und zu erweitern, verwenden die Autoren auch einen kleinen synthetischen Datensatz von Codeübungen.

Quelle: SebastienBubeck via X

Die Rolle des Finetunings

Das Finetuning von Großsprachenmodellen stellt einen anspruchsvollen Prozess der Modellanpassung dar. Dabei wird ein bereits vortrainiertes Modell anhand einer spezifischen Aufgabe oder eines spezifischen Datensatzes weiter angepasst. Das primäre Ziel dieses Prozesses ist es, die Leistung des Modells zu verbessern, indem es an die Besonderheiten und Nuancen der neuen Daten angepasst wird.

Durch das Feintuning wird das Modell in die Lage versetzt, über die im Pretraining erlernte allgemeine Sprachkompetenz hinaus spezialisiertes Wissen zu erwerben. Die Frage, warum Sprachmodelle überhaupt feingetunt werden, lässt sich im Wesentlichen durch drei Hauptgründe beantworten:

- Erstens geht es um die so genannte Model Ownership. Das bedeutet, dass das feingetunte Modell der Organisation gehört, die allein über den Zugriff darauf entscheiden kann.

- Zweitens spielt die Domänenexpertise eine wichtige Rolle. Da die meisten Sprachmodelle auf allgemeinen Daten vortrainiert werden, kann eine Organisation, die über domänenspezifische Daten verfügt, diese für das Feintuning verwenden. Dies verbessert die Qualität der Modellantworten, da das Modell mit den Unternehmensdaten vertraut ist.

- Der dritte Grund betrifft die Datensicherheit und den Datenschutz. Da die Daten eines Unternehmens in der Regel nicht öffentlich sind und als Unternehmenskapital gelten, sollten diese Daten nicht veröffentlicht oder ins Internet gestellt werden. Daher können die Modelle effektiv innerhalb der Organisation verfeinert und genutzt werden, ohne dass die Daten jemals in eine Cloud oder ähnliches gelangen. Dieser Ansatz ist insbesondere für Krankenhäuser, Hedgefonds und ähnliche Institutionen relevant. Das Finetuning bringt jedoch auch einige Nachteile mit sich. Dazu gehören vor allem die Kosten für das Finetuning und die Expertise, die für das Finetuning solcher Modelle erforderlich ist.

Ein wichtiger Aspekt ist die Strukturierung der Daten, damit die Feinabstimmung erfolgreich durchgeführt werden kann. Darüber hinaus muss evaluiert werden, ob das verfeinerte Modell tatsächlich leistungsfähig ist. Dies erfordert in der Regel eine direkte menschliche Überprüfung, die mit erheblichen Kosten verbunden sein kann.

Unter den richtigen Bedingungen kann Feintuning also sehr nützlich sein. Je kleiner ein Sprachmodell ist, desto weniger Ressourcen werden sowohl für das Training als auch für den Betrieb benötigt. Aus Gründen der Kosteneffizienz ist es daher oft ratsam, ein kleineres Netz zu wählen, wenn es eine vergleichbare Leistung erbringt.

Ausblick

Die Entscheidung für ein großes oder ein kleines LLM-Modell hängt stark von der Organisation und dem spezifischen Anwendungsfall ab. Generell lässt sich sagen, dass kleinere Modelle in der Regel kostengünstiger sind als größere. Sie können jedoch auch anfälliger für Probleme wie Verzerrungen sein, da sie oft auf spezifischem und nicht allgemeinem Wissen trainiert wurden. Dies kann dazu führen, dass sie nicht in der Lage sind, vollständig zu verallgemeinern, sondern nur in ihrem Spezialgebiet effektiv sind.

Ein Vorteil kleinerer Modelle ist jedoch, dass sie gut an ihren spezifischen Bereich angepasst werden können, was die Entwicklung eines maßgeschneiderten Modells für eine bestimmte Anwendung ermöglicht. Dies erfordert jedoch einen höheren Aufwand in Bezug auf Engineering, Expertise in Large Language Models (LLMs) und Ressourcen.

Es ist immer sorgfältig abzuwägen, ob man ein großes Modell verwendet, das durch Prompts an die spezifische Aufgabe angepasst wird, oder ob man mehrere kleine Modelle verwendet, die parallel laufen und in der Regel nur für eine spezifische Aufgabe optimiert sind. Die Verwendung von sehr vielen kleinen Modellen kann am Ende sogar ressourcenintensiver sein als ein großes Modell.

Ihr möchtet mehr über spannende Themen aus der adesso-Welt erfahren? Dann werft auch einen Blick in unsere bisher erschienenen Blog-Beiträge.

Auch interessant: