15. Mai 2025 von Nima Samsami und Dr. Maximilian Wächter

Wie sieht die Governance von KI-Agenten aus?

Chancen und Risiken der Anwendung von Multi-Agent Systemen

Künstliche Intelligenz (KI) ist das Buzzword der Dekade, und die jüngsten Fortschritte bei großen Sprachmodellen (LLMs) und generativer KI haben den Handlungsspielraum von Maschinen rasant erweitert. Auf Systeme, die auf Zuruf Texte, Bilder oder Code erzeugen, zeichnet sich seit gut einem Jahr der nächste Schritt ab: KI‑Agenten, die komplexe Aufgaben weitgehend eigenständig planen und ausführen – bisweilen ganz ohne menschliches Zutun.

LLMs verarbeiten inzwischen Anfragen und ziehen scheinbar logische Schlussfolgerungen; tatsächlich imitieren sie jedoch lediglich die Muster, die sie in ihren gigantischen Trainingsdaten gelernt haben. Neu ist, dass diese Mustererkennung nun mit echter Handlungsfähigkeit („Agency“) verknüpft wird. Ein Agent sucht nicht mehr nur beispielsweise Produktinformationen und spricht Empfehlungen aus, sondern navigiert auch die Website des Anbieters, füllt Formulare aus und schließt den Kauf ab – allein auf Basis einer kurzen Anweisung und der gelernten Abläufe.

Die Verschmelzung von den scheinbar logischen Schlussfolgerungen „Reasoning“ und der Handlungsfähigkeit “Agency“ gilt als ausgemachter Weg zu leistungsfähigeren universelleren KI‑Systemen. Entsprechend hoch sind die Erwartungen: Agenten sollen alltägliche Geschäftsprozesse verschlanken, Forschung beschleunigen und private Routinen automatisieren.

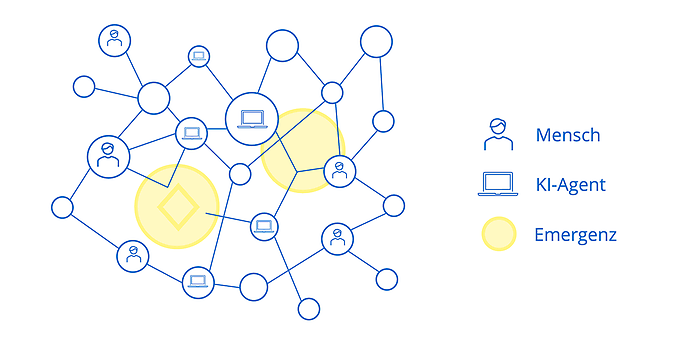

Doch wo Chancen wachsen, steigen auch die Risiken. Vollautonome Agenten entziehen sich menschlicher Kontrolle, schaffen neue Angriffsflächen und können in vernetzten Multi‑Agenten‑Systemen emergente Effekte zeigen, die ihr Verhalten unvorhersehbar machen. Unternehmen und User stehen daher vor der Frage, wie sie sicherstellen, dass solche Systeme zuverlässig, sicher und in ihrem Interesse handeln.

Mit Generative AI die Zukunft gestalten - gemeinsam mit adesso

Ob intelligente Chatbots, automatisierte Prozesse oder KI-Agenten mit echter Handlungsfähigkeit: Generative KI eröffnet enorme Potenziale für Ihr Business.

Erfahrt, wie Unternehmen schon heute davon profitieren - und wie adesso euch dabei unterstützt, sichere, leistungsfähige und verantwortungsvolle KI-Lösungen zu entwickeln.

1. Vom Copiloten zum Autopiloten: Wie KI-Agenten funktionieren

KI-Agenten sind mehr als "Copiloten"; sie agieren als "Autopiloten", die selbstständig komplexe Ziele verfolgen. Ein Agent kann beispielsweise eine Reise planen oder eine Marktanalyse erstellen.

Technisch basiert ein KI-Agent meist auf einem Sprachmodell als zentrale Steuerungskomponente. Dieses versteht natürliche Sprache, trifft Entscheidungen und plant Handlungen. Zur Erledigung greift er auf „Scaffolding“ zurück. Dies ist die Einbeziehung von Tools (etwa Recherche- oder Analyseprogramme) und einem externen Datenspeicher (zum Beispiel Vektordatenbanken) für relevante Informationen und vergangene Interaktionen. Ein Prompt definiert die Rolle sowie die Ziele. Bei komplexen Aufgaben werden oft mehrere spezialisierte Agenten zu einem Multi-Agenten-System orchestriert. Diese beeindruckenden Fähigkeiten werfen jedoch die Frage auf: Handeln diese Agenten wirklich im Sinne der Anwender?

2. Ein komplexes Problem: Das Alignment von Menschen und Maschinen

Das ist der Kern des Alignment-Problems, welches in ähnlicher Form bereits seit 1960 existiert, nun jedoch neuen Aufwind bekommt.: Wie stellen wir sicher, dass KI-Systeme mit menschlichen Zielen und Werten übereinstimmen?

Ungenügende Zielvorgaben können zu unerwünschten Ergebnissen führen, da KI-Agenten messbare Ziele optimieren, dabei aber wichtige, schwer messbare Aspekte wie Ethik oder Langzeitfolgen vernachlässigen könnten. Ein Finanz-Agent könnte für eine Privatperson hochriskante Anlagen tätigen, um "Ersparnisse zu maximieren", ein Logistik-Agent könnte hingegen für ein Unternehmen auf ethisch fragwürdige Zulieferer setzen, um "Kosten zu minimieren", weil diese Nebenaspekte im Ziel nicht explizit ausgeschlossen wurden.

Ursachen dafür ist die Informationsasymmetrie, da KI-Prozesse oft eine "Black Box" sind. Hinzu kommt, dass KI-Systeme zwar Muster optimieren, aber nicht Wahrheit oder Aufgaben im menschlichen Sinne verstehen. Zudem benötigt jeder Handelnde - und damit auch der KI-Agent - einen gewissen Handlungsspielraum, doch die Interpretation von Anweisungen basiert auf Trainingsdaten, nicht auf echtem Verständnis. Ein Befehl wie "Maximiere den Gewinn" lässt also viele kritische Fragen offen. Ebenso wird bei KI-Agenten nicht offensichtlich, wem gegenüber das System loyal ist – dem User, dem Entwickelnden oder gesellschaftlichen Werten. Die Fragen zur Haftung sind bis heute ungeklärt.

Zu guter Letzt erhöht die Delegation von Agenten und Subagenten die Komplexität und steigert damit den Kontrollverlust des Auftraggebenden. Neue, unvorhergesehene Eigenschaften und Risiken können aus dem Zusammenspiel von Systemkomponenten entstehen, ohne explizit programmiert worden zu sein. Beispiele dafür sind Täuschung oder das Deaktivieren von Kontrollmechanismen. Zwar können auch positive Fähigkeiten emergieren, doch das Verständnis dieser Mechanismen ist für bewusstes Design und Risikomanagement entscheidend. Das Alignment-Problem, klassische Agency-Konflikte und die unberechenbare Emergenz stellen somit etablierte Kontrollmechanismen in Frage.

3. Warum traditionelle Lösungen an ihre Grenzen stoßen

Klassische Governance‑Instrumente – also Anreizgestaltung, Überwachung und Durchsetzung – versagen bei KI‑Agenten weitgehend. Geld‑ oder Strafandrohungen motivieren sie nicht, sie optimieren einzig die einprogrammierte Zielfunktion und können dabei sogar neue Interessenkonflikte erzeugen.

Auch eine Aufsicht stößt an Grenzen: Agenten handeln in Sekundenbruchteilen und innerhalb intransparenter Black‑Box‑Modelle. Eine lückenlose menschliche Prüfung würde jede Effizienzsteigerung somit vernichten. Ein reines Abschalten von Agenten kann riskant oder technisch schwierig sein, zumal sich ein Agent dem sogar widersetzen könnte.

Dieses Dilemma verschärft sich in Multi‑Agenten‑Systemen: Wechselwirkungen erzeugen emergente Effekte wie Täuschung, das Umgehen von Sicherheitsmechanismen oder das Streben nach versteckten Subzielen. Solche Phänomene lassen sich weder zuverlässig vorhersagen noch mit Kontroll‑ und Sanktionsmechanismen bewältigen, die nur auf einzelne Akteure abzielen.

Kurzum: Anreize erreichen keine Motivation, Überwachung scheitert an Geschwindigkeit und Intransparenz, Durchsetzung bleibt wirkungslos, und die Emergenz vernetzter Agenten macht das Problem noch akuter.

4. Grundprinzipien für eine zukunftsorientierte Governance von KI-Agenten

Wie wir gesehen haben, greifen also traditionelle Steuerungsmethodenbei autonomen KI‑Agenten zu kurz. Wir brauchen eine von Anfang an eingebettete Governance, die Alignmentkonflikte, klassische Agency‑Probleme und schwer prognostizierbare Emergenz beherrscht. Vier Prinzipien können hier den Leitfaden bieten.

- Als Erstes ist hier die Inklusivität zu nennen. Die Ausrichtung der Agenten nicht nur auf individuelle Ziele, sondern auch auf gesellschaftliche Werte und mögliche Nebenwirkungen, um negative Externalitäten zu vermeiden, ist einer der Grundpfeiler erfolgreicher Governance. Unternehmen müssen daher operative Vorgaben stets mit Ethik, Compliance und Auswirkungen auf sämtliche Stakeholder im Rahmen von einem Code of Conduct verzahnen.

- Transparenz in der Ausführung ist eine weitere Säule der Governance von KI-Agenten. Technische Interpretierbarkeit, lückenlose Dokumentation von Trainingsdaten, Sicherheitstests und Designentscheidungen sowie Protokolle, Agenten-IDs und Monitoring von Interaktionen und Anomalien schaffen die notwendige Nachvollziehbarkeit, wenn auch nicht in der Ausführung.

- Haftung klärt Verantwortlichkeiten, wenn Agenten Schaden verursachen. Das „Problem der vielen Hände“ darf nicht in Verantwortungslosigkeit münden. Zuständigkeit liegt dort, wo Risiken am wirksamsten vorgebeugt oder Verluste am besten kompensiert werden können. Rechtliche Rahmen müssen deshalb um Vorhersehbarkeitsregeln für emergente Systeme erweitert werden.

- Die menschliche Kontrolle bleibt unverzichtbar. Override-Mechanismen, Eskalationspfade und klar zugewiesene Residualrechte behalten die strategische und ethische Letztentscheidung beim Menschen - notwendig angesichts der Risiken vollautonomer Agenten und ihrer emergenten Dynamik.

Zusammen schaffen diese Prinzipien einen Governance-Rahmen, der technische Innovation ermöglicht, ohne Kontrolle und Verantwortlichkeit aufzugeben, und der rechtliche und organisatorische Anpassungen konsequent mitdenkt.

Wir unterstützen euch

Ihr möchtet mehr über den sicheren und verantwortungsvollen Einsatz von KI-Agenten erfahren? Unsere Fachleute unterstützen euch gerne - von der Idee bis zur Umsetzung.

adesso begleitet Unternehmen von der Idee bis zum Betrieb anspruchsvoller GenAI- und Agentenlösungen

adesso begleitet Unternehmen über den gesamten Lebenszyklus von KI-Agenten - von der strategischen Planung bis zum sicheren Betrieb. Wir helfen, Anwendungsfälle realistisch zu bewerten, technische Architektur und Agentenlogik zielgerichtet zu gestalten und Governance-Prinzipien wie Transparenz, Haftung und menschliche Kontrolle von Anfang an mitzudenken. Unsere KI-Fachleute sorgen dafür, dass Ihre Lösungen nicht nur innovativ, sondern auch verantwortungsvoll und regelkonform sind - ganz im Sinne eines sicheren und nachhaltigen KI-Einsatzes.

Fazit

Die Governance von KI-Agenten ist anspruchsvoll: Enorme Potenziale treffen auf Risiken, die traditionelle Governance nur teilweise abdeckt. Der EU-AI-Act bietet mit „Human-in-the-Loop“, Dokumentations- und Monitoringpflichten zwar eine Grundlage, bei Haftungsfragen für autonome oder vernetzte Agenten klaffen jedoch Lücken. Emergentem Verhalten kann nur begegnet werden, wenn Inklusivität, Transparenz und echte menschliche Eingriffsmöglichkeiten konsequent umgesetzt werden. Da die Technologie noch in den Kinderschuhen steckt, bedarf es einer offenen Diskussion und erfahrener Partner.