4. Dezember 2023 von Till Möller

Ein Vergleich von drei Methoden zur Anomalieerkennung

In meinem Blog-Beitrag zum Thema „Machine Learning in der Smart Product Platform“ bin ich auf die Anomalieerkennung im Zusammenhang mit Predictive Maintenance eingegangen. Im Folgenden möchte ich nun einen Überblick über die verschiedenen Möglichkeiten der Anomalieerkennung geben.

Wie bereits im oben genannten Blog-Beitrag beschrieben, bietet die Anomalieerkennung eine Vielzahl von Methoden, die sich in ihrer Anwendung, Komplexität und der Erkennung verschiedener Anomalietypen unterscheiden. Diese Methoden reichen von statistischen Ansätzen über Clustering-Verfahren bis hin zu distanzbasierten Methoden, die darauf abzielen, Unregelmäßigkeiten in den Daten aufzudecken. Im Laufe der Zeit haben sich auch Ansätze aus dem Bereich des maschinellen Lernens und des Deep Learning etabliert. Bekannte Ansätze sind in diesem Zusammenhang Support Vector Machines, Ensemble-Methoden, Autoencoder, rekurrente neuronale Netze und Transformer.

Im Folgenden werden ausgewählte Ansätze zur Erkennung von Anomalien näher betrachtet. Wie bereits erwähnt, unterscheiden sich diese Methoden erheblich in ihrer Anwendung und Komplexität. Statistische Verfahren sind schnell und einfach anzuwenden. Sie verwenden statistische Metriken zur Analyse von Anomalien. Aufgrund ihrer Einfachheit weisen sie jedoch Schwächen bei der Erkennung komplexer Anomalien auf. Ansätze des maschinellen Lernens und des Deep Learning versprechen hingegen eine Verbesserung der Anomalieerkennung. Dies geht jedoch mit einem erhöhten Bedarf an Rechenleistung und Trainingsdaten einher - oder es ist eine aufwändige Vorverarbeitung der Daten notwendig.

Anomalieerkennung im Machine- und Deep-Learning-Bereich

Die Ansätze im Bereich des Machine und Deep Learning können in die Kategorien „Supervised“ und „Unsupervised“ unterteilt werden.

- Supervised bedeutet, dass Daten mit bekannten Anomalien während des Modelltrainings verwendet werden. Dieser Ansatz bildet die Grundlage für den Aufbau eines Vorhersagemodells, das Vertrauen in seine Vorhersagen vermittelt, da die Vorhersagequalität für die bekannten Anomalien beurteilt werden kann. Zu den Methoden in diesem Bereich gehören k-Nearest Neighbors, überwachte neuronale Netze, Support Vector Machines und Decision Trees. Da Anomalien bei der vorausschauenden Instandhaltung in der Praxis selten sind, ist es schwierig, Daten mit Anomalien zu sammeln.

- Unsupervised bedeutet, dass Daten mit unbekannten Anomalien zum Training verwendet werden. Diesem Ansatz liegt die theoretische Annahme zugrunde, dass nur ein kleiner, statistisch auffälliger Teil der Daten Anomalien aufweist. In diesem Zusammenhang werden Methoden wie Autoencoder, k-Means, Decision Trees und Transformer verwendet. Ein Vorteil dieses Ansatzes ist, dass Anomalien in den Daten vorhergesagt werden können, ohne dass die Anomalien vorher bekannt sein müssen. Dies kann besonders nützlich sein, wenn eine Maschine zum ersten Mal in Betrieb genommen wird.

Im Folgenden werfen wir einen Blick auf die drei ausgewählten Methoden IsolationForest, TranAD und AnomalyTransformer.

Methoden zur Anomalieerkennung: ein Überblick

IsolationForest ist eine unüberwachte Methode, die sich hervorragend für die Analyse von zeitlich ungeordneten oder geordneten Daten eignet. Diese Daten können eine (univariate) oder mehrere (multivariate) Dimensionen haben. Die Methodik von IsolationForest basiert auf einem Ensemble-Ansatz, der die Vorhersagen mehrerer Decision Trees kombiniert. Jeder einzelne Baum in diesem Ensemble hat die Aufgabe, die Anomalien von den normalen Datenpunkten zu isolieren. Die Funktionsweise dieses Ansatzes basiert auf der Annahme, dass Anomalien in der Regel in geringer Tiefe im Baum auftreten. Die endgültige Vorhersage des IsolationForests ergibt sich aus dem Mittelwert der Vorhersagen aller einzelnen Decision Trees. Diese einfache, aber effektive Methode ermöglicht es, Anomalien in den Daten zu isolieren und so potenziell anomales Verhalten oder Muster zu identifizieren.

Die beiden Methoden TranAD und AnomalyTransformer sind unsupervised State-of-the-Art Ansätze. Beide Methoden verwenden unterschiedliche Entscheidungskriterien und basieren auf der Transformer-Architektur, einer Architektur, die zuerst im Zusammenhang mit Large Language Models aufgetaucht ist und den sogenannten Attention-Mechanismus verwendet (wie beispielsweise ChatGPT). TranAD verwendet als Kriterium die mittlere quadratische Abweichung zwischen der ursprünglichen Eingabe und der Rekonstruktion dieses Signals durch den Transformer. Der AnomalyTransformer hingegen kombiniert die mittlere quadratische Abweichung mit einer Assoziationsdiskrepanz, um ein Entscheidungskriterium, den Anomalie-Score, zu erhalten. Die Assoziationsdiskrepanz ist ein Maß, das zusammen mit dem AnomalyTransformer eingeführt wurde, da die mittlere quadratische Abweichung nicht für alle Arten von Anomalien gut funktioniert. Beide Ansätze bestimmen dann auf der Grundlage der Trainingsdaten einen Schwellenwert, der auf den Anomaliescore angewendet wird. Alle Datenpunkte, deren Anomaliescores über dem Schwellenwert liegen, werden als Anomalie betrachtet. Weitere Details zu den beiden Ansätzen finden sich in den entsprechenden Dokumenten. Im Folgenden werden die drei Ansätze bewertet.

Evaluierung des IsolationForest, TranAD und des AnomalyTransfoermers

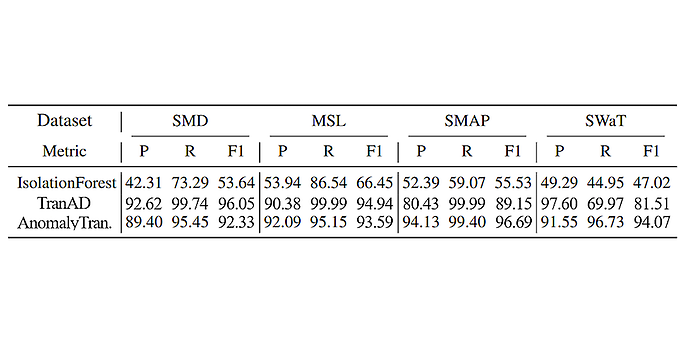

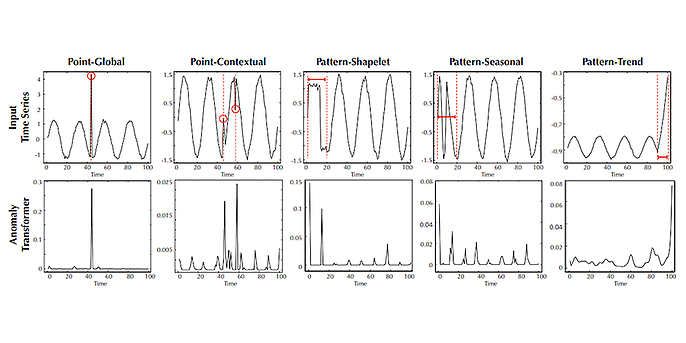

Ziel der vorliegenden Evaluierung war es, die drei Ansätze an den im Blog-Beitrag beschriebenen Anomaliekategorien zu testen. Wie die folgende Tabelle zeigt, war eine Evaluierung der Ansätze an den Referenzdatensätzen SMD, MSL, SMAP7 und SWaT nicht notwendig, da für diese bereits Ergebnisse in Veröffentlichungen vorlagen. Für die beiden Transformer-Ansätze konnten die vorliegenden Ergebnisse in eigenen Tests auf Basis der Code-Repositories der Veröffentlichungen bestätigt werden. Zur Evaluierung der Anomaliekategorien wurden geeignete Datensätze mit dem NeurIPS-TS-Datensatzgenerator erzeugt. Jeder Datensatz besteht aus einer Zeitreihe, die genau einer der Anomaliekategorien zugeordnet ist: global, kontextuell, kollektiv, saisonal oder trendbasiert. Die Entwicklerinnen und Entwickler des AnomalyTransformers liefern bereits Ergebnisse für den NeurIPS-TS Datensatz. Abbildung eins zeigt die entsprechenden Anomaliescores für die Eingabeserien. Mit unserer Version des NeurIPS-TS Datensatzes und des Code Repositories ist es uns nicht gelungen, Ergebnisse in der gleichen Qualität zu erzeugen. Dennoch halten wir diesen Ansatz weiterhin für relevant, insbesondere aufgrund des vielversprechenden Kriteriums zur Berechnung der Anomaliescores. Es sind jedoch weitere Untersuchungen erforderlich, um festzustellen, wie dieser Ansatz in der Praxis effektiv eingesetzt werden kann.

Tabelle 1: Evaluierung der drei Ansätze auf den vier Benchmark-Datensätzen SMD, MSL, SMAP, SWaT. Folgende Metriken sind dargestellt: (P)recision, (R)ecall und (F1)-Score. Die Ergebnisse zu IsolationForest stammen aus dem AnomalyTransformer Paper. (Quelle: vgl. AnomalyTransformer3 und TranAD2)

Abbildung 1: Eingabeserien und zugehörige Anomaliescores. Die roten Punkte und -Flächen stellen Anomalien dar. (Quelle: vgl. AnomalyTransformer)

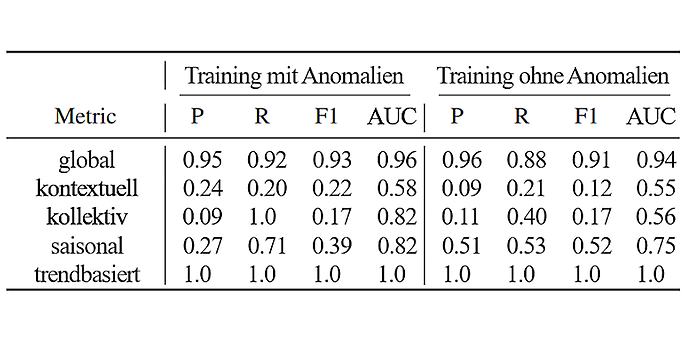

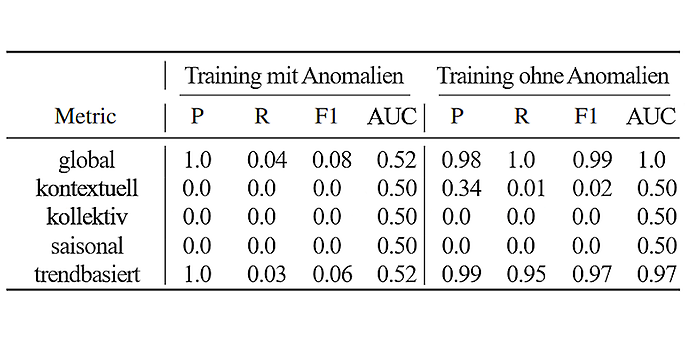

Im Folgenden werden die Ergebnisse der Ansätze TranAD und IsolationForest vorgestellt. Zur Durchführung der Experimente wurde der jeweilige Datensatz in folgende Datenausschnitte unterteilt: Trainingsdaten, Validierung 1, Validierung 2 und Testdaten.

Für die Evaluierung von TranAD wurden die Trainingsdaten und Validierung 1 verwendet, um den Transformer für insgesamt 25 Epochen zu trainieren. Anschließend wurde ein optimaler Schwellenwert für die Anomaliescores auf dem Validierung-2-Datensatz mittels manueller Gittersuche ermittelt. Die endgültigen Ergebnisse wurden auf dem Testdatensatz erzielt.

Bei der Evaluierung von IsolationForest wurde der Trainingsdatensatz verwendet, um das Modell zu trainieren. Validierung 2 wurde verwendet, um die besten Parameter für das Modell in einer automatischen Gittersuche aus einem vordefinierten Parametergitter zu finden. Mehrere Schwellenwerte wurden ausprobiert und derjenige mit den besten Ergebnissen ausgewählt. Der Schwellenwert wurde auf das 0,001-Perzentil der Trainingsdaten festgelegt. Die endgültige Evaluierung wurde mit den Testdaten durchgeführt.

Für beide Tests wurde untersucht, wie sich die Ergebnisse unterscheiden, wenn bereits Anomalien in den Trainings- und Validierungsdaten vorhanden sind. Die Werte für (P)recision, (R)ecall, ROC AUC und der (F1)-Score wurden jeweils auf zwei Dezimalstellen gerundet angegeben. Abbildung 1 zeigt schematisch die Ergebnisse des AnomalyTransformers. Tabelle 2 zeigt die Ergebnisse von TranAD und Tabelle 3 die Ergebnisse von IsolationForest.

Tabelle 2: Ergebnisse der TranAD-Evaluierung

Tabelle 3: Ergebnisse der IsolationForest-Evaluierung

Es zeigt sich, dass TranAD gute Ergebnisse für globale und Trendanomalien liefert, unabhängig davon, ob die Anomalien bereits in den Trainingsdaten vorhanden sind oder nicht. Die Ergebnisse für alle anderen Kategorien sind jedoch von schlechter bis mäßiger Qualität. Für den IsolationForest mit der von uns gewählten Methode zur Bestimmung der Anomalien (manueller Schwellwert) ist ein Training mit Daten ohne Anomalien besser. Es bestätigt sich auch, dass der IsolationForest Probleme hat, komplexere Anomalietypen zu erkennen. Hingegen ist die Leistung bei globalen und trendbasierten Anomalien hervorragend, da sich diese Anomalien stark von normalen Daten unterscheiden.

Fazit

Zusammenfassend kann gesagt werden, dass nicht jede Methode für jeden Anwendungsfall geeignet ist, da nicht alle Anomaliekategorien gleich gut erkannt werden. Bevor aufwendige State-of-the-Art-Methoden eingesetzt werden, sollte geprüft werden, ob weniger aufwendige Methoden ebenfalls geeignet sein könnten. Darüber hinaus halte ich es für sinnvoll, in Zukunft bei neuen Methoden klar anzugeben, für welche Anomaliekategorien sie am besten geeignet sind. Dies würde die Auswahl der geeigneten Methode für den individuellen Anwendungsfall beschleunigen und sicherer machen.

Wenn ihr weitere Fragen habt oder Beratung in diesem Kontext benötigt, sprecht uns gerne unverbindlich an. Unsere Expertinnen und Experten freuen sich auf eure Kontaktaufnahme.

Jetzt unverbindlich Kontakt aufnehmen

Weitere spannende Themen aus der adesso-Welt findet ihr in unseren bisher erschienenen Blog-Beiträgen.

Auch interessant: